commit

441a4583c3

100 changed files with 257537 additions and 0 deletions

BIN

Presentation/My Seminar - Version 3.pdf

View File

BIN

Presentation/My Seminar - Version 3.pptx

View File

BIN

Presentation/Thesis final presentation (Finalest Final).pdf

View File

BIN

Presentation/Thesis final presentation (Finalest Final).pptx

View File

+ 0

- 0

Readme.md

View File

BIN

Refrences/1- Online Display Advertising Markets - A Literature Review and Future Directions.pdf

View File

BIN

Refrences/10- Gradient-Based Learning Applied to Document Recognition.pdf

View File

BIN

Refrences/11- A limited memory BFGS-type method for large-scale unconstrained optimization.pdf

View File

BIN

Refrences/12- Web-Scale Bayesian CTR Prediction for Sponsored Search Advertising in Microsoft's Bing Search Engine.pdf

View File

BIN

Refrences/13- Factorization Machines.pdf

View File

BIN

Refrences/14- Field-aware Factorization Machines for CTR Prediction.pdf

View File

BIN

Refrences/15- Field Aware Factorization Machines in a Real-world Online Advertising System.pdf

View File

BIN

Refrences/16- Field-weighted Factorization Machines for Click-Through Rate Prediction in Display Advertising.pdf

View File

BIN

Refrences/17- Bayesian Factorization Machines.pdf

View File

BIN

Refrences/18- Sparse Factorization Machines for Click-through Rate Prediction.pdf

View File

BIN

Refrences/19- Attentional Factorization Machines; Learning the Weight of Feature Interactions via Attention Networks.pdf

View File

BIN

Refrences/2- A Survey on Real Time Bidding Advertising .pdf

View File

BIN

Refrences/20- Dropout; A Simple Way to Prevent Neural Networks from Overfitting.pdf

View File

BIN

Refrences/22- Deep Learning based Recommender System A Survey and new prespectives.pdf

View File

BIN

Refrences/23- Deep CTR Prediction in Display Advertising.pdf

View File

BIN

Refrences/24- Deep Residual Learning for Image Recognition.pdf

View File

BIN

Refrences/25- Rectifed linear units improve restricted Boltzmann Machines.pdf

View File

BIN

Refrences/26- Entity Embeddings of Categorical Variables.pdf

View File

BIN

Refrences/27- Batch Normalization; Accelerating Deep Network Training by Reducing Internal Covariate Shift.pdf

View File

BIN

Refrences/28- DeepFM; A Factorization-Machine based Neural Network for CTR Prediction.pdf

View File

BIN

Refrences/29- DeepFM; An End-to-End Wide & Deep Learning Framework for CTR Prediction.pdf

View File

BIN

Refrences/3- Revenue Models for Demand Side Platforms in Real Time Bidding Advertising.pdf

View File

BIN

Refrences/30- Wide & Deep Learning for Recommender Systems.pdf

View File

BIN

Refrences/31- A New Approach for Advertising CTR Prediction Based on Deep Neural Network via Attention Mechanism.pdf

View File

BIN

Refrences/32- Modular Learning in Neural Networks.pdf

View File

BIN

Refrences/33- The Mathematical Theory of Communication.pdf

View File

BIN

Refrences/34- On the Dimensionality of Embeddings for Sparse Features and Data.pdf

View File

BIN

Refrences/35- Mixed Dimension Embeddings with Application to Memory-Efficient Recommendation Systems.pdf

View File

BIN

Refrences/36- Neural Collaborative Filtering.pdf

View File

BIN

Refrences/37- Rectifier Nonlinearities Improve Neural Network Acoustic Models.pdf

View File

BIN

Refrences/38- Visualizing Data using t-SNE.pdf

View File

BIN

Refrences/4- Class Imbalance Problem.pdf

View File

+ 215396

- 0

Refrences/4- Encyclopedia of Machine Learning adn Data Mining.pdf

File diff suppressed because it is too large

View File

BIN

Refrences/5- High dimensionality; The latest challenge to data analysis.pdf

View File

BIN

Refrences/6- Facing the cold start problem in recommender systems.pdf

View File

BIN

Refrences/7- Solving the Cold-Start Problem in Recommender Systems with Social Tags.pdf

View File

BIN

Refrences/8- A Training Algorithm for Optimal Margin Classifiers.pdf

View File

BIN

Refrences/9- Learning Piece-wise Linear Models from Large Scale Data for Ad Click Prediction.pdf

View File

+ 447

- 0

Thesis/IEEEabrv.bib

View File

| @@ -0,0 +1,447 @@ | |||

| IEEEabrv.bib | |||

| V1.12 (2007/01/11) | |||

| Copyright (c) 2002-2007 by Michael Shell | |||

| See: http://www.michaelshell.org/ | |||

| for current contact information. | |||

| BibTeX bibliography string definitions of the ABBREVIATED titles of | |||

| IEEE journals and magazines and online publications. | |||

| This file is designed for bibliography styles that require | |||

| abbreviated titles and is not for use in bibliographies that | |||

| require full-length titles. | |||

| Support sites: | |||

| http://www.michaelshell.org/tex/ieeetran/ | |||

| http://www.ctan.org/tex-archive/macros/latex/contrib/IEEEtran/ | |||

| and/or | |||

| http://www.ieee.org/ | |||

| Special thanks to Laura Hyslop and ken Rawson of IEEE for their help | |||

| in obtaining the information needed to compile this file. Also, | |||

| Volker Kuhlmann and Moritz Borgmann kindly provided some corrections | |||

| and additions. | |||

| ************************************************************************* | |||

| Legal Notice: | |||

| This code is offered as-is without any warranty either expressed or | |||

| implied; without even the implied warranty of MERCHANTABILITY or | |||

| FITNESS FOR A PARTICULAR PURPOSE! | |||

| User assumes all risk. | |||

| In no event shall IEEE or any contributor to this code be liable for | |||

| any damages or losses, including, but not limited to, incidental, | |||

| consequential, or any other damages, resulting from the use or misuse | |||

| of any information contained here. | |||

| All comments are the opinions of their respective authors and are not | |||

| necessarily endorsed by the IEEE. | |||

| This work is distributed under the LaTeX Project Public License (LPPL) | |||

| ( http://www.latex-project.org/ ) version 1.3, and may be freely used, | |||

| distributed and modified. A copy of the LPPL, version 1.3, is included | |||

| in the base LaTeX documentation of all distributions of LaTeX released | |||

| 2003/12/01 or later. | |||

| Retain all contribution notices and credits. | |||

| ** Modified files should be clearly indicated as such, including ** | |||

| ** renaming them and changing author support contact information. ** | |||

| File list of work: IEEEabrv.bib, IEEEfull.bib, IEEEexample.bib, | |||

| IEEEtran.bst, IEEEtranS.bst, IEEEtranSA.bst, | |||

| IEEEtranN.bst, IEEEtranSN.bst, IEEEtran_bst_HOWTO.pdf | |||

| ************************************************************************* | |||

| USAGE: | |||

| \bibliographystyle{mybstfile} | |||

| \bibliography{IEEEabrv,mybibfile} | |||

| where the IEEE titles in the .bib database entries use the strings | |||

| defined here. e.g., | |||

| journal = IEEE_J_AC, | |||

| to yield "{IEEE} Trans. Automat. Contr." | |||

| IEEE uses abbreviated journal titles in their bibliographies - | |||

| this file is suitable for work that is to be submitted to the IEEE. | |||

| For work that requires full-length titles, you should use the full | |||

| titles provided in the companion file, IEEEfull.bib. | |||

| ** NOTES ** | |||

| 1. Journals have been grouped according to subject in order to make it | |||

| easier to locate and extract the definitions for related journals - | |||

| as most works use references that are confined to a single topic. | |||

| Magazines are listed in straight alphabetical order. | |||

| 2. String names are closely based on IEEE's own internal acronyms. | |||

| 3. Abbreviations follow IEEE's style. | |||

| 4. Older, out-of-print IEEE titles are included (but not including titles | |||

| dating prior to IEEE's formation from the IRE and AIEE in 1963). | |||

| 5. The following NEW/current journal definitions have been disabled because | |||

| their abbreviations have not yet been verified: | |||

| STRING{IEEE_J_CBB = "{IEEE/ACM} Trans. Comput. Biology Bioinformatics"} | |||

| STRING{IEEE_J_CJECE = "Canadian J. Elect. Comput. Eng."} | |||

| STRING{IEEE_J_DSC = "{IEEE} Trans. Dependable Secure Comput."} | |||

| STRING{IEEE_O_DSO = "{IEEE} Distrib. Syst. Online"} | |||

| 6. The following OLD journal definitions have been disabled because | |||

| their abbreviations have not yet been found/verified: | |||

| STRING{IEEE_J_BCTV = "{IEEE} Trans. Broadcast Television Receivers"} | |||

| STRING{IEEE_J_EWS = "{IEEE} Trans. Eng. Writing Speech"} | |||

| If you know what the proper abbreviation is for a string in #5 or #6 above, | |||

| email me and I will correct them in the next release. | |||

| IEEE Journals | |||

| aerospace and military | |||

| @STRING{IEEE_J_AES = "{IEEE} Trans. Aerosp. Electron. Syst."} | |||

| @STRING{IEEE_J_ANE = "{IEEE} Trans. Aerosp. Navig. Electron."} | |||

| @STRING{IEEE_J_ANNE = "{IEEE} Trans. Aeronaut. Navig. Electron."} | |||

| @STRING{IEEE_J_AS = "{IEEE} Trans. Aerosp."} | |||

| @STRING{IEEE_J_AIRE = "{IEEE} Trans. Airborne Electron."} | |||

| @STRING{IEEE_J_MIL = "{IEEE} Trans. Mil. Electron."} | |||

| autos, transportation and vehicles (non-aerospace) | |||

| @STRING{IEEE_J_ITS = "{IEEE} Trans. Intell. Transp. Syst."} | |||

| @STRING{IEEE_J_VT = "{IEEE} Trans. Veh. Technol."} | |||

| @STRING{IEEE_J_VC = "{IEEE} Trans. Veh. Commun."} | |||

| circuits, signals, systems, audio and controls | |||

| @STRING{IEEE_J_SPL = "{IEEE} Signal Process. Lett."} | |||

| @STRING{IEEE_J_ASSP = "{IEEE} Trans. Acoust., Speech, Signal Process."} | |||

| @STRING{IEEE_J_AU = "{IEEE} Trans. Audio"} | |||

| @STRING{IEEE_J_AUEA = "{IEEE} Trans. Audio Electroacoust."} | |||

| @STRING{IEEE_J_AC = "{IEEE} Trans. Autom. Control"} | |||

| @STRING{IEEE_J_CAS = "{IEEE} Trans. Circuits Syst."} | |||

| @STRING{IEEE_J_CASVT = "{IEEE} Trans. Circuits Syst. Video Technol."} | |||

| @STRING{IEEE_J_CASI = "{IEEE} Trans. Circuits Syst. {I}"} | |||

| @STRING{IEEE_J_CASII = "{IEEE} Trans. Circuits Syst. {II}"} | |||

| in 2004 CASI and CASII renamed part title to CASI_RP and CASII_EB, respectively. | |||

| @STRING{IEEE_J_CASI_RP = "{IEEE} Trans. Circuits Syst. {I}"} | |||

| @STRING{IEEE_J_CASII_EB = "{IEEE} Trans. Circuits Syst. {II}"} | |||

| @STRING{IEEE_J_CT = "{IEEE} Trans. Circuit Theory"} | |||

| @STRING{IEEE_J_CST = "{IEEE} Trans. Control Syst. Technol."} | |||

| @STRING{IEEE_J_SP = "{IEEE} Trans. Signal Process."} | |||

| @STRING{IEEE_J_SU = "{IEEE} Trans. Sonics Ultrason."} | |||

| @STRING{IEEE_J_SAP = "{IEEE} Trans. Speech Audio Process."} | |||

| @STRING{IEEE_J_UE = "{IEEE} Trans. Ultrason. Eng."} | |||

| @STRING{IEEE_J_UFFC = "{IEEE} Trans. Ultrason., Ferroelectr., Freq. Control"} | |||

| communications | |||

| @STRING{IEEE_J_COML = "{IEEE} Commun. Lett."} | |||

| @STRING{IEEE_J_JSAC = "{IEEE} J. Sel. Areas Commun."} | |||

| @STRING{IEEE_J_COM = "{IEEE} Trans. Commun."} | |||

| @STRING{IEEE_J_COMT = "{IEEE} Trans. Commun. Technol."} | |||

| @STRING{IEEE_J_WCOM = "{IEEE} Trans. Wireless Commun."} | |||

| components, packaging and manufacturing | |||

| @STRING{IEEE_J_ADVP = "{IEEE} Trans. Adv. Packag."} | |||

| @STRING{IEEE_J_CHMT = "{IEEE} Trans. Compon., Hybrids, Manuf. Technol."} | |||

| @STRING{IEEE_J_CPMTA = "{IEEE} Trans. Compon., Packag., Manuf. Technol. {A}"} | |||

| @STRING{IEEE_J_CPMTB = "{IEEE} Trans. Compon., Packag., Manuf. Technol. {B}"} | |||

| @STRING{IEEE_J_CPMTC = "{IEEE} Trans. Compon., Packag., Manuf. Technol. {C}"} | |||

| @STRING{IEEE_J_CAPT = "{IEEE} Trans. Compon. Packag. Technol."} | |||

| @STRING{IEEE_J_CAPTS = "{IEEE} Trans. Compon. Packag. Technol."} | |||

| @STRING{IEEE_J_CPART = "{IEEE} Trans. Compon. Parts"} | |||

| @STRING{IEEE_J_EPM = "{IEEE} Trans. Electron. Packag. Manuf."} | |||

| @STRING{IEEE_J_MFT = "{IEEE} Trans. Manuf. Technol."} | |||

| @STRING{IEEE_J_PHP = "{IEEE} Trans. Parts, Hybrids, Packag."} | |||

| @STRING{IEEE_J_PMP = "{IEEE} Trans. Parts, Mater., Packag."} | |||

| CAD | |||

| @STRING{IEEE_J_TCAD = "{IEEE} J. Technol. Comput. Aided Design"} | |||

| @STRING{IEEE_J_CAD = "{IEEE} Trans. Comput.-Aided Design Integr. Circuits Syst."} | |||

| coding, data, information, knowledge | |||

| @STRING{IEEE_J_IT = "{IEEE} Trans. Inf. Theory"} | |||

| @STRING{IEEE_J_KDE = "{IEEE} Trans. Knowl. Data Eng."} | |||

| computers, computation, networking and software | |||

| @STRING{IEEE_J_C = "{IEEE} Trans. Comput."} | |||

| @STRING{IEEE_J_CAL = "{IEEE} Comput. Archit. Lett."} | |||

| disabled till definition is verified | |||

| STRING{IEEE_J_DSC = "{IEEE} Trans. Dependable Secure Comput."} | |||

| @STRING{IEEE_J_ECOMP = "{IEEE} Trans. Electron. Comput."} | |||

| @STRING{IEEE_J_EVC = "{IEEE} Trans. Evol. Comput."} | |||

| @STRING{IEEE_J_FUZZ = "{IEEE} Trans. Fuzzy Syst."} | |||

| @STRING{IEEE_J_IFS = "{IEEE} Trans. Inf. Forensics Security"} | |||

| @STRING{IEEE_J_MC = "{IEEE} Trans. Mobile Comput."} | |||

| @STRING{IEEE_J_NET = "{IEEE/ACM} Trans. Netw."} | |||

| @STRING{IEEE_J_NN = "{IEEE} Trans. Neural Netw."} | |||

| @STRING{IEEE_J_PDS = "{IEEE} Trans. Parallel Distrib. Syst."} | |||

| @STRING{IEEE_J_SE = "{IEEE} Trans. Softw. Eng."} | |||

| computer graphics, imaging, and multimedia | |||

| @STRING{IEEE_J_JDT = "{IEEE/OSA} J. Display Technol."} | |||

| @STRING{IEEE_J_IP = "{IEEE} Trans. Image Process."} | |||

| @STRING{IEEE_J_MM = "{IEEE} Trans. Multimedia"} | |||

| @STRING{IEEE_J_VCG = "{IEEE} Trans. Vis. Comput. Graphics"} | |||

| cybernetics, ergonomics, robots, man-machine, and automation | |||

| @STRING{IEEE_J_ASE = "{IEEE} Trans. Autom. Sci. Eng."} | |||

| @STRING{IEEE_J_JRA = "{IEEE} J. Robot. Autom."} | |||

| @STRING{IEEE_J_HFE = "{IEEE} Trans. Hum. Factors Electron."} | |||

| @STRING{IEEE_J_MMS = "{IEEE} Trans. Man-Mach. Syst."} | |||

| @STRING{IEEE_J_PAMI = "{IEEE} Trans. Pattern Anal. Mach. Intell."} | |||

| in 1989 JRA became RA | |||

| in August 2004, RA split into ASE and RO | |||

| @STRING{IEEE_J_RA = "{IEEE} Trans. Robot. Autom."} | |||

| @STRING{IEEE_J_RO = "{IEEE} Trans. Robot."} | |||

| @STRING{IEEE_J_SMC = "{IEEE} Trans. Syst., Man, Cybern."} | |||

| @STRING{IEEE_J_SMCA = "{IEEE} Trans. Syst., Man, Cybern. {A}"} | |||

| @STRING{IEEE_J_SMCB = "{IEEE} Trans. Syst., Man, Cybern. {B}"} | |||

| @STRING{IEEE_J_SMCC = "{IEEE} Trans. Syst., Man, Cybern. {C}"} | |||

| @STRING{IEEE_J_SSC = "{IEEE} Trans. Syst. Sci. Cybern."} | |||

| earth, wind, fire and water | |||

| @STRING{IEEE_J_GE = "{IEEE} Trans. Geosci. Electron."} | |||

| @STRING{IEEE_J_GRS = "{IEEE} Trans. Geosci. Remote Sens."} | |||

| @STRING{IEEE_J_GRSL = "{IEEE} Geosci. Remote Sens. Lett."} | |||

| @STRING{IEEE_J_OE = "{IEEE} J. Ocean. Eng."} | |||

| education, engineering, history, IEEE, professional | |||

| disabled till definition is verified | |||

| STRING{IEEE_J_CJECE = "Canadian J. Elect. Comput. Eng."} | |||

| @STRING{IEEE_J_PROC = "Proc. {IEEE}"} | |||

| @STRING{IEEE_J_EDU = "{IEEE} Trans. Educ."} | |||

| @STRING{IEEE_J_EM = "{IEEE} Trans. Eng. Manag."} | |||

| disabled till definition is verified | |||

| STRING{IEEE_J_EWS = "{IEEE} Trans. Eng. Writing Speech"} | |||

| @STRING{IEEE_J_PC = "{IEEE} Trans. Prof. Commun."} | |||

| electromagnetics, antennas, EMI, magnetics and microwave | |||

| @STRING{IEEE_J_AWPL = "{IEEE} Antennas Wireless Propag. Lett."} | |||

| @STRING{IEEE_J_MGWL = "{IEEE} Microw. Guided Wave Lett."} | |||

| IEEE seems to want "Compon." here, not "Comp." | |||

| @STRING{IEEE_J_MWCL = "{IEEE} Microw. Wireless Compon. Lett."} | |||

| @STRING{IEEE_J_AP = "{IEEE} Trans. Antennas Propag."} | |||

| @STRING{IEEE_J_EMC = "{IEEE} Trans. Electromagn. Compat."} | |||

| @STRING{IEEE_J_MAG = "{IEEE} Trans. Magn."} | |||

| @STRING{IEEE_J_MTT = "{IEEE} Trans. Microw. Theory Tech."} | |||

| @STRING{IEEE_J_RFI = "{IEEE} Trans. Radio Freq. Interference"} | |||

| @STRING{IEEE_J_TJMJ = "{IEEE} Transl. J. Magn. Jpn."} | |||

| energy and power | |||

| @STRING{IEEE_J_EC = "{IEEE} Trans. Energy Convers."} | |||

| @STRING{IEEE_J_PEL = "{IEEE} Power Electron. Lett."} | |||

| @STRING{IEEE_J_PWRAS = "{IEEE} Trans. Power App. Syst."} | |||

| @STRING{IEEE_J_PWRD = "{IEEE} Trans. Power Del."} | |||

| @STRING{IEEE_J_PWRE = "{IEEE} Trans. Power Electron."} | |||

| @STRING{IEEE_J_PWRS = "{IEEE} Trans. Power Syst."} | |||

| industrial, commercial and consumer | |||

| @STRING{IEEE_J_APPIND = "{IEEE} Trans. Appl. Ind."} | |||

| @STRING{IEEE_J_BC = "{IEEE} Trans. Broadcast."} | |||

| disabled till definition is verified | |||

| STRING{IEEE_J_BCTV = "{IEEE} Trans. Broadcast Television Receivers"} | |||

| @STRING{IEEE_J_CE = "{IEEE} Trans. Consum. Electron."} | |||

| @STRING{IEEE_J_IE = "{IEEE} Trans. Ind. Electron."} | |||

| @STRING{IEEE_J_IECI = "{IEEE} Trans. Ind. Electron. Contr. Instrum."} | |||

| @STRING{IEEE_J_IA = "{IEEE} Trans. Ind. Appl."} | |||

| @STRING{IEEE_J_IGA = "{IEEE} Trans. Ind. Gen. Appl."} | |||

| @STRING{IEEE_J_IINF = "{IEEE} Trans. Ind. Informat."} | |||

| @STRING{IEEE_J_PSE = "{IEEE} J. Product Safety Eng."} | |||

| instrumentation and measurement | |||

| @STRING{IEEE_J_IM = "{IEEE} Trans. Instrum. Meas."} | |||

| insulation and materials | |||

| @STRING{IEEE_J_JEM = "{IEEE/TMS} J. Electron. Mater."} | |||

| @STRING{IEEE_J_DEI = "{IEEE} Trans. Dielectr. Electr. Insul."} | |||

| @STRING{IEEE_J_EI = "{IEEE} Trans. Electr. Insul."} | |||

| mechanical | |||

| @STRING{IEEE_J_MECH = "{IEEE/ASME} Trans. Mechatronics"} | |||

| @STRING{IEEE_J_MEMS = "J. Microelectromech. Syst."} | |||

| medical and biological | |||

| @STRING{IEEE_J_BME = "{IEEE} Trans. Biomed. Eng."} | |||

| Note: The B-ME journal later dropped the hyphen and became the BME. | |||

| @STRING{IEEE_J_B-ME = "{IEEE} Trans. Bio-Med. Eng."} | |||

| @STRING{IEEE_J_BMELC = "{IEEE} Trans. Bio-Med. Electron."} | |||

| disabled till definition is verified | |||

| STRING{IEEE_J_CBB = "{IEEE/ACM} Trans. Comput. Biology Bioinformatics"} | |||

| @STRING{IEEE_J_ITBM = "{IEEE} Trans. Inf. Technol. Biomed."} | |||

| @STRING{IEEE_J_ME = "{IEEE} Trans. Med. Electron."} | |||

| @STRING{IEEE_J_MI = "{IEEE} Trans. Med. Imag."} | |||

| @STRING{IEEE_J_NB = "{IEEE} Trans. Nanobiosci."} | |||

| @STRING{IEEE_J_NSRE = "{IEEE} Trans. Neural Syst. Rehabil. Eng."} | |||

| @STRING{IEEE_J_RE = "{IEEE} Trans. Rehabil. Eng."} | |||

| optics, lightwave and photonics | |||

| @STRING{IEEE_J_PTL = "{IEEE} Photon. Technol. Lett."} | |||

| @STRING{IEEE_J_JLT = "J. Lightw. Technol."} | |||

| physics, electrons, nanotechnology, nuclear and quantum electronics | |||

| @STRING{IEEE_J_EDL = "{IEEE} Electron Device Lett."} | |||

| @STRING{IEEE_J_JQE = "{IEEE} J. Quantum Electron."} | |||

| @STRING{IEEE_J_JSTQE = "{IEEE} J. Sel. Topics Quantum Electron."} | |||

| @STRING{IEEE_J_ED = "{IEEE} Trans. Electron Devices"} | |||

| @STRING{IEEE_J_NANO = "{IEEE} Trans. Nanotechnol."} | |||

| @STRING{IEEE_J_NS = "{IEEE} Trans. Nucl. Sci."} | |||

| @STRING{IEEE_J_PS = "{IEEE} Trans. Plasma Sci."} | |||

| reliability | |||

| IEEE seems to want "Mat." here, not "Mater." | |||

| @STRING{IEEE_J_DMR = "{IEEE} Trans. Device Mater. Rel."} | |||

| @STRING{IEEE_J_R = "{IEEE} Trans. Rel."} | |||

| semiconductors, superconductors, electrochemical and solid state | |||

| @STRING{IEEE_J_ESSL = "{IEEE/ECS} Electrochem. Solid-State Lett."} | |||

| @STRING{IEEE_J_JSSC = "{IEEE} J. Solid-State Circuits"} | |||

| @STRING{IEEE_J_ASC = "{IEEE} Trans. Appl. Supercond."} | |||

| @STRING{IEEE_J_SM = "{IEEE} Trans. Semicond. Manuf."} | |||

| sensors | |||

| @STRING{IEEE_J_SENSOR = "{IEEE} Sensors J."} | |||

| VLSI | |||

| @STRING{IEEE_J_VLSI = "{IEEE} Trans. {VLSI} Syst."} | |||

| IEEE Magazines | |||

| @STRING{IEEE_M_AES = "{IEEE} Aerosp. Electron. Syst. Mag."} | |||

| @STRING{IEEE_M_HIST = "{IEEE} Ann. Hist. Comput."} | |||

| @STRING{IEEE_M_AP = "{IEEE} Antennas Propag. Mag."} | |||

| @STRING{IEEE_M_ASSP = "{IEEE} {ASSP} Mag."} | |||

| @STRING{IEEE_M_CD = "{IEEE} Circuits Devices Mag."} | |||

| @STRING{IEEE_M_CAS = "{IEEE} Circuits Syst. Mag."} | |||

| @STRING{IEEE_M_COM = "{IEEE} Commun. Mag."} | |||

| @STRING{IEEE_M_COMSOC = "{IEEE} Commun. Soc. Mag."} | |||

| @STRING{IEEE_M_CIM = "{IEEE} Comput. Intell. Mag."} | |||

| CSEM changed to CSE in 1999 | |||

| @STRING{IEEE_M_CSE = "{IEEE} Comput. Sci. Eng."} | |||

| @STRING{IEEE_M_CSEM = "{IEEE} Comput. Sci. Eng. Mag."} | |||

| @STRING{IEEE_M_C = "{IEEE} Computer"} | |||

| @STRING{IEEE_M_CAP = "{IEEE} Comput. Appl. Power"} | |||

| @STRING{IEEE_M_CGA = "{IEEE} Comput. Graph. Appl."} | |||

| @STRING{IEEE_M_CONC = "{IEEE} Concurrency"} | |||

| @STRING{IEEE_M_CS = "{IEEE} Control Syst. Mag."} | |||

| @STRING{IEEE_M_DTC = "{IEEE} Des. Test. Comput."} | |||

| @STRING{IEEE_M_EI = "{IEEE} Electr. Insul. Mag."} | |||

| @STRING{IEEE_M_ETR = "{IEEE} ElectroTechnol. Rev."} | |||

| @STRING{IEEE_M_EMB = "{IEEE} Eng. Med. Biol. Mag."} | |||

| @STRING{IEEE_M_EMR = "{IEEE} Eng. Manag. Rev."} | |||

| @STRING{IEEE_M_EXP = "{IEEE} Expert"} | |||

| @STRING{IEEE_M_IA = "{IEEE} Ind. Appl. Mag."} | |||

| @STRING{IEEE_M_IM = "{IEEE} Instrum. Meas. Mag."} | |||

| @STRING{IEEE_M_IS = "{IEEE} Intell. Syst."} | |||

| @STRING{IEEE_M_IC = "{IEEE} Internet Comput."} | |||

| @STRING{IEEE_M_ITP = "{IEEE} {IT} Prof."} | |||

| @STRING{IEEE_M_MICRO = "{IEEE} Micro"} | |||

| @STRING{IEEE_M_MW = "{IEEE} Microw. Mag."} | |||

| @STRING{IEEE_M_MM = "{IEEE} Multimedia"} | |||

| @STRING{IEEE_M_NET = "{IEEE} Netw."} | |||

| IEEE's editorial manual lists "Pers. Commun.", | |||

| but "Personal Commun. Mag." seems to be what is used in the journals | |||

| @STRING{IEEE_M_PCOM = "{IEEE} Personal Commun. Mag."} | |||

| @STRING{IEEE_M_POT = "{IEEE} Potentials"} | |||

| CAP and PER merged to form PE in 2003 | |||

| @STRING{IEEE_M_PE = "{IEEE} Power Energy Mag."} | |||

| @STRING{IEEE_M_PER = "{IEEE} Power Eng. Rev."} | |||

| @STRING{IEEE_M_PVC = "{IEEE} Pervasive Comput."} | |||

| @STRING{IEEE_M_RA = "{IEEE} Robot. Autom. Mag."} | |||

| @STRING{IEEE_M_SAP = "{IEEE} Security Privacy"} | |||

| @STRING{IEEE_M_SP = "{IEEE} Signal Process. Mag."} | |||

| @STRING{IEEE_M_S = "{IEEE} Softw."} | |||

| @STRING{IEEE_M_SPECT = "{IEEE} Spectr."} | |||

| @STRING{IEEE_M_TS = "{IEEE} Technol. Soc. Mag."} | |||

| @STRING{IEEE_M_VT = "{IEEE} Veh. Technol. Mag."} | |||

| @STRING{IEEE_M_WC = "{IEEE} Wireless Commun. Mag."} | |||

| @STRING{IEEE_M_TODAY = "Today's Engineer"} | |||

| IEEE Online Publications | |||

| @STRING{IEEE_O_CSTO = "{IEEE} Commun. Surveys Tuts."} | |||

| disabled till definition is verified | |||

| STRING{IEEE_O_DSO = "{IEEE} Distrib. Syst. Online"} | |||

| -- | |||

| EOF | |||

+ 17

- 0

Thesis/abstract_en.tex

View File

| @@ -0,0 +1,17 @@ | |||

| % !TEX encoding = UTF-8 Unicode | |||

| \thispagestyle{empty} | |||

| \begin{latin} | |||

| \centerline{\textbf{\large{Abstract}}} | |||

| \begin{quote} | |||

| \small | |||

| Event history analysis is a classic problem in stochastic process, that recently attracts the researchers' attention in complex networks. The goal is to model the time of events, like check in a restaurant check-in or post a message, given their history, and then control them. In this thesis we try to improve both aspects of the problem... | |||

| \vskip 0.3cm | |||

| \textbf{Keywords:} \textit{Event history, complex network, stochastic point process, Hawkes process, spatio-temporal events, optimal control, stochastic differential equations} | |||

| \end{quote} | |||

| \end{latin} | |||

+ 18

- 0

Thesis/abstract_fa.tex

View File

| @@ -0,0 +1,18 @@ | |||

| % !TEX encoding = UTF-8 Unicode | |||

| \thispagestyle{empty} | |||

| \centerline{\textbf{\large{چکیده}}} | |||

| \begin{quote} | |||

| امروزه تبلیغات برخط بخش زیادی از وبسایتها و برنامههای موبایلی را دربر گرفته است. در این نوع تبلیغات به محض تعامل کاربر با سایت یا برنامه موبایل باید در کسری از ثانیه در مورد اینکه چه تبلیغی به وی نشان داده شود تصمیم گرفته شود\footnote{استاندارد پذیرفته شده در دنیا حدود 100 میلیثانیه است}. در سامانههای تبلیغ برخط، درآمد این سیستمها معمولا پس از کلیک کاربر روی تبلیغ یا تعامل کاربر با تبلیغ صورت میگیرد و لذا روش معمول این است که برای انتخاب تبلیغ برای نمایش به کاربر، ابتدا احتمال کلیک یا تعامل کاربر با تبلیغات مختلف را محاسبه کرده و سپس بر اساس این احتمال و مبلغ درآمد به ازای تبلیغات مختلف، یک تبلیغ را به عنوان تبلیغ برنده انتخاب و به کاربر نمایش میدهند. لذا یکی از مهمترین مسائل در تبلیغات برخط پیشبینی احتمال کلیک کاربر بر روی تبلیغات مختلف است که مورد توجه زیادی در حوزه تحقیقات دانشگاهی قرار گرفته است. محاسبه دقیق این احتمال تعامل، از طرفی باعث نمایش تبلیغات مرتبطتر به کاربران و افزایش رضایت آنها خواهد شد و از طرفی دیگر درآمد سیستمهای تبلیغاتی را افزایش خواهد داد. | |||

| تحقیقات قبلی در حوزه پیشبینی احتمال کلیک و تعامل، مساله را به یک مساله دستهبندی دودویی تبدیل میکنند و با استفاده از اطلاعات موجود در تاریخچه که به سه دستهی سمت کاربر، سمت تبلیغ دهنده و سمت نمایش دهنده تقسیم میشود، سعی در پیشبینی احتمال تعامل دارند. چالشهایی نظیر نامتوازن بودن کلاسها، تنک بودن دادهها، بعد زیاد و شروع سرد، این مساله را به کلی از مسائل سنتی دستهبندی متفاوت میکنند. روشهای موجود در این حوزه را میتوان به دو دسته روشهای کم عمق و روشهای ژرف دستهبندی کرد. با توجه به سادگی پیادهسازی و قابلیت موازیسازی، روشهای کم عمق در عمل استفاده بیشتری داشتهاند. | |||

| در این پژوهش، با بررسی مسالهی پیشبینی احتمال نرخ تعامل کاربران با تبلیغات، و همچنین با تاکید بر چالشهای گفته شده، روش جدیدی برای حل این مساله پیشنهاد میدهیم. برای طراحی روش پیشنهادی، از مجموعهی متنوعی از ایدههای موجود و همچنین جدید بهره گرفته و این مدل را در راستای مقاوم بودن در برابر چالشهای مساله، طراحی نموده و با بررسی معیارهای ارزیابی نظیر مساحت تحت منحنی، دقت و بازیابی، عملکرد آن را روی مجموعه دادههای استاندارد میآزماییم. با بررسی نتایج آزمایشها، نتیجه میگیریم مدل پیشنهادی عملکرد قابل قبولی ارائه کرده و در نتیجه قابل آزمایش در شرایط آنلاین و واقعی است. | |||

| \vskip 1cm | |||

| \textbf{کلمات کلیدی:} \textiranic{ | |||

| تبلیغات نمایشی، کاربر، احتمال تعامل، بردارهای تعبیه، تعامل بین ویژگیها | |||

| } | |||

| \end{quote} | |||

+ 13

- 0

Thesis/acknowledge.tex

View File

| @@ -0,0 +1,13 @@ | |||

| %% acknowledgement page | |||

| %\thispagestyle{empty} | |||

| %\cleardoublepage % | |||

| %\vspace{4cm} | |||

| % | |||

| %{\nastaliq | |||

| % تقدیم به بهار...% | |||

| %} | |||

| %\newpage | |||

| %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% | |||

| %% ستایش | |||

| %\baselineskip=.750cm | |||

| % \newpage\clearpage | |||

+ 69

- 0

Thesis/app1.aux

View File

| @@ -0,0 +1,69 @@ | |||

| \relax | |||

| \providecommand\zref@newlabel[2]{} | |||

| \providecommand\hyper@newdestlabel[2]{} | |||

| \zref@newlabel{zref@29}{\abspage{14}\page{9}\pagevalue{9}} | |||

| \@writefile{toc}{\contentsline {chapter}{پیوست\nobreakspace {}\numberline {آ}فرآیندهای نقطهای}{9}{appendix.Alph1}} | |||

| \@writefile{lof}{\addvspace {10\p@ }} | |||

| \@writefile{lot}{\addvspace {10\p@ }} | |||

| \newlabel{Chap:App1}{{آ}{9}{فرآیندهای نقطهای}{appendix.Alph1}{}} | |||

| \@writefile{lof}{\contentsline {figure}{\numberline {آ-1}{\ignorespaces فرآیند پواسن یکبُعدی\relax }}{9}{figure.caption.5}} | |||

| \newlabel{fig:2dpp}{{آ-1}{9}{فرآیند پواسن یکبُعدی\relax }{figure.caption.5}{}} | |||

| \citation{williams1991probability} | |||

| \citation{shalizialmost} | |||

| \citation{shalizialmost} | |||

| \@writefile{lof}{\contentsline {figure}{\numberline {آ-2}{\ignorespaces فرآیند پواسن چندبُعدی، استقلال آماری در توزیع نقاط\relax }}{10}{figure.caption.6}} | |||

| \newlabel{fig:ndpp}{{آ-2}{10}{فرآیند پواسن چندبُعدی، استقلال آماری در توزیع نقاط\relax }{figure.caption.6}{}} | |||

| \@writefile{toc}{\contentsline {section}{\numberline {آ-1}تعریف فرآیند پواسن}{10}{section.Alph1.1}} | |||

| \zref@newlabel{footdir@62}{\abspage{15}} | |||

| \zref@newlabel{zref@30}{\abspage{15}\page{10}\pagevalue{10}} | |||

| \zref@newlabel{footdir@64}{\abspage{15}} | |||

| \zref@newlabel{footdir@63}{\abspage{15}} | |||

| \@setckpt{app1}{ | |||

| \setcounter{page}{11} | |||

| \setcounter{equation}{1} | |||

| \setcounter{enumi}{0} | |||

| \setcounter{enumii}{0} | |||

| \setcounter{enumiii}{0} | |||

| \setcounter{enumiv}{0} | |||

| \setcounter{footnote}{1} | |||

| \setcounter{mpfootnote}{2} | |||

| \setcounter{part}{0} | |||

| \setcounter{chapter}{1} | |||

| \setcounter{section}{1} | |||

| \setcounter{subsection}{0} | |||

| \setcounter{subsubsection}{0} | |||

| \setcounter{paragraph}{0} | |||

| \setcounter{subparagraph}{0} | |||

| \setcounter{figure}{2} | |||

| \setcounter{table}{0} | |||

| \setcounter{parentequation}{0} | |||

| \setcounter{ALC@unique}{0} | |||

| \setcounter{ALC@line}{0} | |||

| \setcounter{ALC@rem}{0} | |||

| \setcounter{ALC@depth}{0} | |||

| \setcounter{float@type}{8} | |||

| \setcounter{algorithm}{0} | |||

| \setcounter{ContinuedFloat}{0} | |||

| \setcounter{KVtest}{0} | |||

| \setcounter{subfigure}{0} | |||

| \setcounter{subfigure@save}{0} | |||

| \setcounter{lofdepth}{1} | |||

| \setcounter{subtable}{0} | |||

| \setcounter{subtable@save}{0} | |||

| \setcounter{lotdepth}{1} | |||

| \setcounter{pp@next@reset}{0} | |||

| \setcounter{zpage}{10} | |||

| \setcounter{@pps}{1} | |||

| \setcounter{@ppsavesec}{1} | |||

| \setcounter{@ppsaveapp}{0} | |||

| \setcounter{Item}{0} | |||

| \setcounter{Hfootnote}{30} | |||

| \setcounter{Hy@AnnotLevel}{0} | |||

| \setcounter{bookmark@seq@number}{13} | |||

| \setcounter{su@anzahl}{0} | |||

| \setcounter{LT@tables}{0} | |||

| \setcounter{LT@chunks}{0} | |||

| \setcounter{footdir@label}{64} | |||

| \setcounter{shadetheorem}{2} | |||

| \setcounter{section@level}{1} | |||

| } | |||

+ 44

- 0

Thesis/app1.tex

View File

| @@ -0,0 +1,44 @@ | |||

| % !TEX encoding = UTF-8 Unicode | |||

| \chapter{فرآیندهای نقطهای}\label{Chap:App1} | |||

| یکی از معروفترین توزیعها در آمار و احتمال، توزیع پواسن است که حالت حدی توزیع دوجملهای است وقتی که تعداد آزمایشها زیاد و احتمال موفقیت کم باشد. اگر تعداد متوسط موفقیتها را $\mu=Np$ بنامیم میتوان نشان داد: | |||

| \begin{equation} | |||

| \text{\lr{Pois}} (r|\mu) = \lim_{n\rightarrow\infty} \text{\lr{Bin}}(r|N,p) = \frac{\mu^r e^{-\mu}}{r!} | |||

| %\mathcal{P} | |||

| \end{equation} | |||

| که $\mu$ میانگین توزیع پواسن نیز است. به طور مشابه فرآیند پواسن برای شمارش پدیدههایی مانند تابش ذرات رادیواکتیو، تماسهای گرفته شده با مرکز تلفن یا درخواستها از یک وبسرور کار میرود که به صورت رویدادهایی مستقل در زمان پیوسته اتفاق میافتند، شکل \ref{fig:2dpp} را ببینید. در حالت چندبُعدی میتوان توزیع ستارگان در آسمان یا درختان در جنگل را که هیچ الگو یا نظم خاصی ندارد مانند شکل \ref{fig:ndpp} با فرآیند پواسن مدل کرد. در واقع پدیدههایی که از عوامل مستقل زیادی به وجود میآیند که هر کدام احتمال کمی دارند، به خوبی با فرآیند پواسن مدل میشوند. ویژگی اصلی این فرآیند تصادفی استقلال آماری آن است به طوری که تعداد نقاط در ناحیههایی که با هم اشتراک ندارند از هم مستقل هستند. | |||

| در این بخش ابتدا تعریف و خواص توزیع پواسن آورده میشود. سپس قضایای مهم در مورد فرآیند پواسن بیان میشود. در بخش بعد انواع فرآیندهایی که از روی پواسن تعریف میشوند مانند فرآیند پواسن نشاندار، فرآیند هاوکس و فرآیند کاوکس آورده میشود. در اتنها دو روش نمونه برداری اوگاتا و باریکسازی شرح داده میشود. | |||

| \begin{figure} | |||

| \center | |||

| \includegraphics{images/2dpp} | |||

| \caption{فرآیند پواسن یکبُعدی} | |||

| \label{fig:2dpp} | |||

| \end{figure} | |||

| \section{تعریف فرآیند پواسن} | |||

| \begin{figure} | |||

| \center | |||

| \includegraphics{images/poiss-process} | |||

| \caption{فرآیند پواسن چندبُعدی، استقلال آماری در توزیع نقاط} | |||

| \label{fig:ndpp} | |||

| \end{figure} | |||

| برای تعریف فرآیندهای تصادفی دو دیدگاه وجود دارد؛ مجموعه متغیرهای تصادفی و تابع تصادفی. برای تعریف فرآیند تصادفی ابتدا متغیر تصادفی را تعریف میکنیم \cite{williams1991probability}. | |||

| \begin{definition}%[ویلیامز \cite{williams1991probability}] | |||

| متغیر تصادفی $X$ تابعی اندازهپذیر از فضای احتمال $(\Omega,\mathcal{F},P)$ به | |||

| \trans{فضای اندازهپذیر}{Measurable Space} $(\Xi,\mathcal{E})$ | |||

| است بدین معنا که نگاشت معکوس $E\in\mathcal{E}$ عضو $\mathcal{F}$ است، $X^{-1}(E) \in \mathcal{F}$. برای تعریف توزیع احتمال متغیر تصادفی، فضای اندازه پذیر را $(\mathbb{R}, \mathcal{B}(\mathbb{R}))$ در نظر میگیرند\footnote{ | |||

| مجموعه $\mathcal{B}(\mathbb{R})$ از کامل کردن $\{(-\infty,q)|q\in\mathbb{Q}\}$ به دست میآید، یعنی کوچکترین میدان سیگمایی که مجموعه نیمبازههای کسری عضو آن باشند. | |||

| }. | |||

| اکنون توزیع تجمعی را میتوان به صورت | |||

| $F_X(x)=P(X^{-1}(-\infty,x])=P(\{\omega|X(\omega)\leq x\})$ | |||

| نوشت. | |||

| \end{definition} | |||

| از اینجا به بعد فرض میکنیم فضای احتمال $(\Omega,\mathcal{F},P)$ را در اختیار داریم که همه متغیرهای تصادفی در آن قابل تعریف هستند. اکنون تعریف فرآیند تصادفی به صورت مجموعهای از متغیرهای تصادفی را میتوان بیان کرد \cite{shalizialmost}. | |||

| \begin{definition}%[شالیزی \cite{shalizialmost}] | |||

| فرآیند تصادفی $\{X_t\}_{t\in \mathcal{T}}$ مجموعهای از متغیرهای تصادفی $X_t$ از فضای احتمال $(\Omega,\mathcal{F},P)$ به فضای اندازهپذیر $(\Xi,\mathcal{E})$ است که با مجموعه $\mathcal{T}$ نمایه میشوند. | |||

| \end{definition} | |||

| برای بیان تعریف دوم، باید ابتدا تابع تصادفی و | |||

| \trans{نمونه مسیر}{Sample path} | |||

| را تعریف کنیم \cite{shalizialmost}. | |||

+ 58

- 0

Thesis/app2.aux

View File

| @@ -0,0 +1,58 @@ | |||

| \relax | |||

| \providecommand\zref@newlabel[2]{} | |||

| \providecommand\hyper@newdestlabel[2]{} | |||

| \zref@newlabel{zref@31}{\abspage{16}\page{11}\pagevalue{11}} | |||

| \@writefile{toc}{\contentsline {chapter}{پیوست\nobreakspace {}\numberline {ب}اثباتها}{11}{appendix.Alph2}} | |||

| \@writefile{lof}{\addvspace {10\p@ }} | |||

| \@writefile{lot}{\addvspace {10\p@ }} | |||

| \newlabel{Chap:App2}{{ب}{11}{اثباتها}{appendix.Alph2}{}} | |||

| \newlabel{app:4c-lglk}{{ب}{11}{اثبات گزاره \ref {thm:4c-lglk}}{section*.7}{}} | |||

| \@setckpt{app2}{ | |||

| \setcounter{page}{13} | |||

| \setcounter{equation}{0} | |||

| \setcounter{enumi}{0} | |||

| \setcounter{enumii}{0} | |||

| \setcounter{enumiii}{0} | |||

| \setcounter{enumiv}{0} | |||

| \setcounter{footnote}{1} | |||

| \setcounter{mpfootnote}{2} | |||

| \setcounter{part}{0} | |||

| \setcounter{chapter}{2} | |||

| \setcounter{section}{0} | |||

| \setcounter{subsection}{0} | |||

| \setcounter{subsubsection}{0} | |||

| \setcounter{paragraph}{0} | |||

| \setcounter{subparagraph}{0} | |||

| \setcounter{figure}{0} | |||

| \setcounter{table}{0} | |||

| \setcounter{parentequation}{0} | |||

| \setcounter{ALC@unique}{0} | |||

| \setcounter{ALC@line}{0} | |||

| \setcounter{ALC@rem}{0} | |||

| \setcounter{ALC@depth}{0} | |||

| \setcounter{float@type}{8} | |||

| \setcounter{algorithm}{0} | |||

| \setcounter{ContinuedFloat}{0} | |||

| \setcounter{KVtest}{0} | |||

| \setcounter{subfigure}{0} | |||

| \setcounter{subfigure@save}{0} | |||

| \setcounter{lofdepth}{1} | |||

| \setcounter{subtable}{0} | |||

| \setcounter{subtable@save}{0} | |||

| \setcounter{lotdepth}{1} | |||

| \setcounter{pp@next@reset}{0} | |||

| \setcounter{zpage}{11} | |||

| \setcounter{@pps}{1} | |||

| \setcounter{@ppsavesec}{1} | |||

| \setcounter{@ppsaveapp}{0} | |||

| \setcounter{Item}{0} | |||

| \setcounter{Hfootnote}{30} | |||

| \setcounter{Hy@AnnotLevel}{0} | |||

| \setcounter{bookmark@seq@number}{14} | |||

| \setcounter{su@anzahl}{0} | |||

| \setcounter{LT@tables}{0} | |||

| \setcounter{LT@chunks}{0} | |||

| \setcounter{footdir@label}{64} | |||

| \setcounter{shadetheorem}{2} | |||

| \setcounter{section@level}{1} | |||

| } | |||

+ 33

- 0

Thesis/app2.tex

View File

| @@ -0,0 +1,33 @@ | |||

| % !TEX encoding = UTF-8 Unicode | |||

| \chapter{اثباتها}\label{Chap:App2} | |||

| %================================================================== | |||

| \section*{اثبات گزاره \ref{thm:4c-lglk}}\label{app:4c-lglk} | |||

| با استفاده از قانون زنجیر در احتمالات میتوان نوشت | |||

| \begin{align} | |||

| &f(\mathcal{D} \vert \theta) = \prod_{i=1}^K f\left((t_i,u_i,p_i)| \mathcal{D}(t_i)\right) \prod_{u=1}^{N} S(T,u) \nonumber | |||

| \end{align} | |||

| که $t_0=0$ و $S_u(T)$ احتمال بقای فرآیند $\lambda_u(t)$ بعد از آخرین رویدادش است. | |||

| \begin{align} | |||

| S_u(T) = \exp\left(-\int_{t_{\vert\mathcal{D}_u\vert}}^T \lambda_{u}(s) ds\right) \nonumber | |||

| \end{align} | |||

| اکنون با استفاده از رابطه فوق میتوان درستنمایی را محاسبه کرد. | |||

| \begin{align} | |||

| &f(\mathcal{D} \vert \theta) | |||

| = \prod_{u=1}^{N} \prod_{i=1}^{\vert\mathcal{D}_u\vert} f\left((t_i,u_i,p_i)| \mathcal{D}(t_i)\right) \prod_{u=1}^{N} S(T,u) \nonumber \\ | |||

| &= \prod_{u=1}^{N} \prod_{i=1}^{\vert\mathcal{D}_u\vert} \lambda_{u}(t_i) \exp\left(-\int_{t_{i-1}}^{t_i} \lambda_{u}(s) ds\right) f_{u}(p_i | t_i) | |||

| \prod_{u=1}^{N} S(T,u) \nonumber | |||

| \end{align} | |||

| \begin{align} | |||

| &= \prod_{u=1}^{N} \exp\left(-\int_0^{t_{\vert\mathcal{D}_u\vert}} \lambda_{u}(s) ds\right) \prod_{i=1}^{\vert\mathcal{D}_u\vert} f_{u}(p_i | t_i) \lambda_{u}(t_i) \prod_{u=1}^{N} S(T,u) \nonumber \\ | |||

| &= \prod_{u=1}^{N} \exp\left(-\int_0^{t_{\vert\mathcal{D}_u\vert}} \lambda_{u}(s) ds\right) S(T,u) | |||

| \prod_{i=1}^{\vert\mathcal{D}_u\vert} f_{u}(p_i | t_i) \lambda_{u}(t_i) \nonumber\\ | |||

| &= \prod_{u=1}^{N} \exp\left(-\int_0^T \lambda_{u}(s) ds\right) | |||

| \prod_{i=1}^{\vert\mathcal{D}_u\vert} f_{u}(p_i | t_i) \lambda_{u}(t_i) \nonumber | |||

| \\ | |||

| &= \prod_{u=1}^{N} \exp\left(-\int_0^T \lambda_{u}(s) ds\right) | |||

| \prod_{u=1}^{N} \prod_{i=1}^{\vert\mathcal{D}_u\vert} f_{u}(p_i | t_i) \lambda_{u}(t_i) \nonumber \\ | |||

| &=\exp\left(-\int_0^T \sum_{u=1}^N \lambda_u(s) ds \right) \prod_{i=1}^K \lambda_{u_i}(t_i) f_{u_i}(p_i|t_i) \nonumber | |||

| \end{align} | |||

+ 183

- 0

Thesis/chap1.aux

View File

| @@ -0,0 +1,183 @@ | |||

| \relax | |||

| \providecommand\zref@newlabel[2]{} | |||

| \providecommand\hyper@newdestlabel[2]{} | |||

| \citation{choi2020online} | |||

| \citation{yuan2014survey} | |||

| \zref@newlabel{zref@2}{\abspage{9}\page{2}\pagevalue{2}} | |||

| \@writefile{toc}{\contentsline {chapter}{فصل\nobreakspace {}\numberline {1}مقدمه}{2}{chapter.1}} | |||

| \@writefile{lof}{\addvspace {10\p@ }} | |||

| \@writefile{lot}{\addvspace {10\p@ }} | |||

| \newlabel{Chap:Chap1}{{1}{2}{مقدمه}{chapter.1}{}} | |||

| \zref@newlabel{footdir@10}{\abspage{9}} | |||

| \zref@newlabel{zref@6}{\abspage{9}\page{2}\pagevalue{2}} | |||

| \zref@newlabel{footdir@8}{\abspage{9}} | |||

| \zref@newlabel{zref@5}{\abspage{9}\page{2}\pagevalue{2}} | |||

| \zref@newlabel{footdir@6}{\abspage{9}} | |||

| \zref@newlabel{zref@4}{\abspage{9}\page{2}\pagevalue{2}} | |||

| \zref@newlabel{footdir@4}{\abspage{9}} | |||

| \zref@newlabel{zref@3}{\abspage{9}\page{2}\pagevalue{2}} | |||

| \zref@newlabel{footdir@14}{\abspage{9}} | |||

| \zref@newlabel{zref@8}{\abspage{9}\page{2}\pagevalue{2}} | |||

| \zref@newlabel{footdir@12}{\abspage{9}} | |||

| \zref@newlabel{zref@7}{\abspage{9}\page{2}\pagevalue{2}} | |||

| \zref@newlabel{footdir@18}{\abspage{9}} | |||

| \zref@newlabel{footdir@5}{\abspage{9}} | |||

| \zref@newlabel{footdir@7}{\abspage{9}} | |||

| \zref@newlabel{footdir@9}{\abspage{9}} | |||

| \zref@newlabel{footdir@11}{\abspage{9}} | |||

| \zref@newlabel{footdir@13}{\abspage{9}} | |||

| \zref@newlabel{footdir@15}{\abspage{9}} | |||

| \@writefile{toc}{\contentsline {section}{\numberline {1-1}معرفی انواع معاملات در تبلیغات نمایشی}{3}{section.1.1}} | |||

| \zref@newlabel{footdir@16}{\abspage{10}} | |||

| \zref@newlabel{zref@9}{\abspage{10}\page{3}\pagevalue{3}} | |||

| \zref@newlabel{footdir@19}{\abspage{10}} | |||

| \zref@newlabel{zref@10}{\abspage{10}\page{3}\pagevalue{3}} | |||

| \zref@newlabel{footdir@21}{\abspage{10}} | |||

| \zref@newlabel{zref@11}{\abspage{10}\page{3}\pagevalue{3}} | |||

| \zref@newlabel{footdir@25}{\abspage{10}} | |||

| \zref@newlabel{zref@13}{\abspage{10}\page{3}\pagevalue{3}} | |||

| \zref@newlabel{footdir@23}{\abspage{10}} | |||

| \zref@newlabel{zref@12}{\abspage{10}\page{3}\pagevalue{3}} | |||

| \zref@newlabel{footdir@27}{\abspage{10}} | |||

| \zref@newlabel{zref@14}{\abspage{10}\page{3}\pagevalue{3}} | |||

| \zref@newlabel{footdir@29}{\abspage{10}} | |||

| \zref@newlabel{zref@15}{\abspage{10}\page{3}\pagevalue{3}} | |||

| \zref@newlabel{footdir@31}{\abspage{10}} | |||

| \zref@newlabel{zref@16}{\abspage{10}\page{3}\pagevalue{3}} | |||

| \zref@newlabel{footdir@33}{\abspage{10}} | |||

| \zref@newlabel{footdir@17}{\abspage{10}} | |||

| \zref@newlabel{footdir@20}{\abspage{10}} | |||

| \zref@newlabel{footdir@22}{\abspage{10}} | |||

| \zref@newlabel{footdir@24}{\abspage{10}} | |||

| \zref@newlabel{footdir@26}{\abspage{10}} | |||

| \zref@newlabel{footdir@28}{\abspage{10}} | |||

| \zref@newlabel{footdir@30}{\abspage{10}} | |||

| \zref@newlabel{footdir@32}{\abspage{10}} | |||

| \citation{yuan2014survey} | |||

| \zref@newlabel{footdir@34}{\abspage{11}} | |||

| \zref@newlabel{zref@17}{\abspage{11}\page{4}\pagevalue{4}} | |||

| \zref@newlabel{footdir@36}{\abspage{11}} | |||

| \zref@newlabel{zref@18}{\abspage{11}\page{4}\pagevalue{4}} | |||

| \zref@newlabel{footdir@38}{\abspage{11}} | |||

| \zref@newlabel{zref@19}{\abspage{11}\page{4}\pagevalue{4}} | |||

| \zref@newlabel{footdir@40}{\abspage{11}} | |||

| \zref@newlabel{zref@20}{\abspage{11}\page{4}\pagevalue{4}} | |||

| \zref@newlabel{footdir@42}{\abspage{11}} | |||

| \zref@newlabel{footdir@35}{\abspage{11}} | |||

| \zref@newlabel{footdir@37}{\abspage{11}} | |||

| \zref@newlabel{footdir@39}{\abspage{11}} | |||

| \zref@newlabel{footdir@41}{\abspage{11}} | |||

| \@writefile{toc}{\contentsline {section}{\numberline {1-2}اجزا و نحوهی اجرای مزایدههای بلادرنگ}{5}{section.1.2}} | |||

| \@writefile{toc}{\contentsline {subsection}{\numberline {1-2-1}کاربر}{5}{subsection.1.2.1}} | |||

| \@writefile{toc}{\contentsline {subsection}{\numberline {1-2-2}ناشر}{5}{subsection.1.2.2}} | |||

| \zref@newlabel{footdir@43}{\abspage{12}} | |||

| \zref@newlabel{zref@21}{\abspage{12}\page{5}\pagevalue{5}} | |||

| \@writefile{toc}{\contentsline {subsection}{\numberline {1-2-3}سکوی سمت تامین}{5}{subsection.1.2.3}} | |||

| \zref@newlabel{footdir@45}{\abspage{12}} | |||

| \zref@newlabel{zref@22}{\abspage{12}\page{5}\pagevalue{5}} | |||

| \zref@newlabel{footdir@51}{\abspage{12}} | |||

| \zref@newlabel{footdir@44}{\abspage{12}} | |||

| \zref@newlabel{footdir@46}{\abspage{12}} | |||

| \@writefile{toc}{\contentsline {subsection}{\numberline {1-2-4}سکوی سمت نیاز}{6}{subsection.1.2.4}} | |||

| \zref@newlabel{footdir@47}{\abspage{13}} | |||

| \zref@newlabel{zref@23}{\abspage{13}\page{6}\pagevalue{6}} | |||

| \zref@newlabel{footdir@49}{\abspage{13}} | |||

| \zref@newlabel{zref@24}{\abspage{13}\page{6}\pagevalue{6}} | |||

| \@writefile{toc}{\contentsline {subsection}{\numberline {1-2-5}تبلیغ کننده}{6}{subsection.1.2.5}} | |||

| \zref@newlabel{footdir@52}{\abspage{13}} | |||

| \zref@newlabel{zref@25}{\abspage{13}\page{6}\pagevalue{6}} | |||

| \@writefile{toc}{\contentsline {subsection}{\numberline {1-2-6}اجرای فرآیند مزایدههای بلادرنگ}{6}{subsection.1.2.6}} | |||

| \zref@newlabel{footdir@54}{\abspage{13}} | |||

| \zref@newlabel{zref@26}{\abspage{13}\page{6}\pagevalue{6}} | |||

| \zref@newlabel{footdir@56}{\abspage{13}} | |||

| \zref@newlabel{zref@27}{\abspage{13}\page{6}\pagevalue{6}} | |||

| \zref@newlabel{footdir@58}{\abspage{13}} | |||

| \zref@newlabel{footdir@48}{\abspage{13}} | |||

| \zref@newlabel{footdir@50}{\abspage{13}} | |||

| \zref@newlabel{footdir@53}{\abspage{13}} | |||

| \zref@newlabel{footdir@55}{\abspage{13}} | |||

| \zref@newlabel{footdir@57}{\abspage{13}} | |||

| \citation{qin2019revenue} | |||

| \@writefile{lof}{\contentsline {figure}{\numberline {1-1}{\ignorespaces فرآیند مزایدهی بلادرنگ \relax }}{7}{figure.caption.4}} | |||

| \providecommand*\caption@xref[2]{\@setref\relax\@undefined{#1}} | |||

| \newlabel{fig:rtb-process}{{1-1}{7}{فرآیند مزایدهی بلادرنگ \relax }{figure.caption.4}{}} | |||

| \zref@newlabel{footdir@59}{\abspage{14}} | |||

| \zref@newlabel{zref@28}{\abspage{14}\page{7}\pagevalue{7}} | |||

| \zref@newlabel{footdir@61}{\abspage{14}} | |||

| \zref@newlabel{zref@29}{\abspage{14}\page{7}\pagevalue{7}} | |||

| \zref@newlabel{footdir@63}{\abspage{14}} | |||

| \zref@newlabel{footdir@60}{\abspage{14}} | |||

| \zref@newlabel{footdir@62}{\abspage{14}} | |||

| \citation{reference/ml/LingS17} | |||

| \citation{pires2019high} | |||

| \citation{journals/eswa/LikaKH14} | |||

| \citation{DBLP:journals/corr/abs-1004-3732} | |||

| \@writefile{toc}{\contentsline {section}{\numberline {1-3}چالشها}{8}{section.1.3}} | |||

| \zref@newlabel{footdir@64}{\abspage{15}} | |||

| \zref@newlabel{zref@30}{\abspage{15}\page{8}\pagevalue{8}} | |||

| \zref@newlabel{footdir@66}{\abspage{15}} | |||

| \zref@newlabel{zref@31}{\abspage{15}\page{8}\pagevalue{8}} | |||

| \zref@newlabel{footdir@68}{\abspage{15}} | |||

| \zref@newlabel{zref@32}{\abspage{15}\page{8}\pagevalue{8}} | |||

| \zref@newlabel{footdir@70}{\abspage{15}} | |||

| \zref@newlabel{zref@33}{\abspage{15}\page{8}\pagevalue{8}} | |||

| \zref@newlabel{footdir@72}{\abspage{15}} | |||

| \zref@newlabel{zref@34}{\abspage{15}\page{8}\pagevalue{8}} | |||

| \zref@newlabel{footdir@74}{\abspage{15}} | |||

| \zref@newlabel{footdir@65}{\abspage{15}} | |||

| \zref@newlabel{footdir@67}{\abspage{15}} | |||

| \zref@newlabel{footdir@69}{\abspage{15}} | |||

| \zref@newlabel{footdir@71}{\abspage{15}} | |||

| \zref@newlabel{footdir@73}{\abspage{15}} | |||

| \@writefile{toc}{\contentsline {section}{\numberline {1-4}هدف پژوهش}{9}{section.1.4}} | |||

| \@writefile{toc}{\contentsline {section}{\numberline {1-5}پرسشهای اساسی پژوهش}{9}{section.1.5}} | |||

| \@writefile{toc}{\contentsline {section}{\numberline {1-6}ساختار رساله}{9}{section.1.6}} | |||

| \@setckpt{chap1}{ | |||

| \setcounter{page}{10} | |||

| \setcounter{equation}{0} | |||

| \setcounter{enumi}{3} | |||

| \setcounter{enumii}{0} | |||

| \setcounter{enumiii}{0} | |||

| \setcounter{enumiv}{0} | |||

| \setcounter{footnote}{5} | |||

| \setcounter{mpfootnote}{0} | |||

| \setcounter{part}{0} | |||

| \setcounter{chapter}{1} | |||

| \setcounter{section}{6} | |||

| \setcounter{subsection}{0} | |||

| \setcounter{subsubsection}{0} | |||

| \setcounter{paragraph}{0} | |||

| \setcounter{subparagraph}{0} | |||

| \setcounter{figure}{1} | |||

| \setcounter{table}{0} | |||

| \setcounter{parentequation}{0} | |||

| \setcounter{ALC@unique}{0} | |||

| \setcounter{ALC@line}{0} | |||

| \setcounter{ALC@rem}{0} | |||

| \setcounter{ALC@depth}{0} | |||

| \setcounter{float@type}{8} | |||

| \setcounter{algorithm}{0} | |||

| \setcounter{ContinuedFloat}{0} | |||

| \setcounter{KVtest}{0} | |||

| \setcounter{subfigure}{0} | |||

| \setcounter{subfigure@save}{0} | |||

| \setcounter{lofdepth}{1} | |||

| \setcounter{subtable}{0} | |||

| \setcounter{subtable@save}{0} | |||

| \setcounter{lotdepth}{1} | |||

| \setcounter{pp@next@reset}{0} | |||

| \setcounter{zpage}{8} | |||

| \setcounter{@pps}{0} | |||

| \setcounter{@ppsavesec}{0} | |||

| \setcounter{@ppsaveapp}{0} | |||

| \setcounter{Item}{3} | |||

| \setcounter{Hfootnote}{33} | |||

| \setcounter{Hy@AnnotLevel}{0} | |||

| \setcounter{bookmark@seq@number}{13} | |||

| \setcounter{su@anzahl}{0} | |||

| \setcounter{LT@tables}{0} | |||

| \setcounter{LT@chunks}{0} | |||

| \setcounter{footdir@label}{74} | |||

| \setcounter{shadetheorem}{0} | |||

| \setcounter{section@level}{1} | |||

| } | |||

+ 2255

- 0

Thesis/chap1.log

File diff suppressed because it is too large

View File

+ 132

- 0

Thesis/chap1.tex

View File

| @@ -0,0 +1,132 @@ | |||

| % !TEX encoding = UTF-8 Unicode | |||

| \chapter{مقدمه}\label{Chap:Chap1} | |||

| %================================================================== | |||

| انسان برای رفع نیازهای خود به اقتصاد وابسته است. برای توسعهی چرخههای اقتصادی، باید عوامل مهمی از قبیل افزایش تولید و گذر از تولید دستی به انبوه و همچنین بازاریابی مناسب را در نظر گرفت. یکی از عوامل دست یافتن به بازاریابی مناسب، انجام تبلیغات صحیح برای محصولات است. | |||

| امروزه با گسترش اینترنت، شاهد تاثیرگذاری آن بر اکثر جنبههای زندگی بشری، از جمله اقتصاد هستیم. یکی از نمودهای این تاثیرگذاری، ظهور تبلیغات آنلاین در مقابل گونههای سنتیِ آن است. مقرون به صرفه بودن، در دسترس بودن در مقیاس جهانی و قابلیت گرفتن بازخورد مستقیم از کاربران مورد نظر از جمله برتریهای قابل توجه تبلیغات آنلاین است. | |||

| تبلیغات آنلاین، به شیوههای متنوعی انجام میشود.\cite{choi2020online} تعدادی از گونههای این نوع تبلیغات، وبسایتها، \trans{شبکههای اجتماعی}{Social Networks}، \trans{تبلیغات کلمه کلیدی}{Keyword Advertising}، \trans{بهینهسازی موتورهای جستجو}{SEO} و \trans{تبلیغات نمایشی}{Display Advertising} هستند. | |||

| در تبلیغات نمایشی، استفاده از \trans{بنر}{Banners}های ثابت، انیمیشنی و ویدیویی و نشان دادن آن به \trans{کاربر}{User} در کادرهای از پیش تعیین شده داخل وبسایتها یا برنامههای موبایل به عنوان روشی کارآمد برای جذب مخاطب به کار میرود؛ اما انتخاب این که کدام بنر در کدام کادر (کدام صفحهی وب) به کدام کاربر نمایش دادهشود، چالش قابل توجهی است. | |||

| \section{معرفی انواع معاملات در تبلیغات نمایشی} | |||

| از آنجا که درآمد بسیاری از صاحبان صفحات وب، تنها از تبلیغات نمایشی انجام شده در وبسایتهایشان حاصل میشود، انتخاب نحوهی قرارداد با \trans{تبلیغ کننده}{Advertisier}ها اهمیت زیادی برای آنها دارد.\cite{yuan2014survey} در این بخش به طور مختصر انواع قراردادهای رایج بین تبلیغات کنندهها و صاحبان صفحات وب را توضیح میدهیم. | |||

| \begin{itemize} | |||

| \item \textbf{قراردادهای مستقیم} | |||

| در ابتدای ظهور تبلیغات آنلاین نمایشی، تبلیغ کننده با صاحب وبسایت \trans{قرارداد مستقیم}{Direct Deas} بسته و با انتخاب یک کادر ثابت در وبسایت و یک بنر تبلیغاتی مشخص، تا مدت (یا تعداد کلیک) مشخصی با نمایش دادن تبلیغ یکسان به تمامی کاربرانی که از آن صفحهی به خصوص بازدید میکردند، تبلیغات خود را نمایش میدادند. با وجود این که تعدادی وبسایت هنوز از چنین روشی استفاده میکنند؛ واضح است که به کار گرفتن آن برای تعداد بالای صفحات و تبلیغات، هزینه و زحمت قابل توجهی را به هر دو طرف معامله تحمیل میکند. به دلیل این مشکل، سراغ دستهای از قراردادها میرویم که به \trans{معاملات برنامهریزی شده}{Programmatic Deals} معروفاند. | |||

| \item \textbf{قراردادهای برنامهریزی شده} | |||

| در بقیهی روشها، که جزء شاخهی برنامهریزی شده طبقه بندی میشوند، با رعایت کردن یک استاندارد مشترک، میزان هزینه و زحمت مورد نیاز کاهش یافته و فرآیند سریعتر انجام میشود. معاملات برنامهریزی شده به دو دستهی \trans{معاملات تضمین شده}{Guaranteed Deals} و \trans{مزایدهی بلادرنگ}{Realtime Bidding (RTB)} تقسیم میشوند. | |||

| \begin{itemize} | |||

| \item \textbf{قراردادهای تضمین شده} | |||

| در این دسته از قراردادها، هزینه و تعداد بنرهایی که باید به کاربران نشان داده شوند، از پیش تعیین میشود. نکتهی حائز اهمیت در این دسته از قراردادها، اضافه شدن سیستمهایی است که به صورت اتوماتیک بخشهای قابل توجهی از فرآیند نمایش تبلیغ را انجام داده و با حذف دخالت انسانی، هزینهها و زحمات کار را به شدت کاهش میدهند. دو دستهی مهم از این قراردادها، دستهی \trans{قراردادهای تضمین شدهی اتوماتیک}{Automated Guaranteed Deals} و \trans{قراردادهای تضمین شدهی برنامهریزی شده}{Programmatic Guaranteed Deals} نامیده میشوند. | |||

| \begin{itemize} | |||

| \item \textbf{قراردادهای تضمین شدهی اتوماتیک} | |||

| همانطور که در بخش قبل گفته شد، در قراردادهای تضمین شدهی اتوماتیک، تمرکز بر \trans{خودکارسازی}{Automation} فرآیند نمایش تبلیغ است. یکی از مهمترین فواید خودکارسازی نمایش تبلیغ برای تبلیغ کننده، امکان تبلیغ همزمان در چندین وبسایت بدون نیاز به عقد چندین قرارداد است. | |||

| \item \textbf{قراردادهای تضمین شدهی برنامهریزی شده} | |||

| در این دسته از قراردادها علاوه بر سادهسازیهایی که در قراردادهای تضمین شدهی اتوماتیک انجام میشود، امکان تنظیمات جزئیتری برای تبلیغ کننده وجود داشته و در نتیجه این دسته از قراردادها بسیار محبوبتر از قراردادهای تضمین شدهی اتوماتیک هستند. در قراردادهای تضمین شدهی برنامه ریزی شده، تبلیغ کننده میتواند با اعمال چندین قاعدهی محدود کننده، نمایش بنر خود را برای کاربران مختلف فیلتر کرده و عملا بنر تبلیغاتی خود را فقط برای کاربرانی با مشخصات از پیش تعیین شده نمایش دهد. به عنوان مثال فرض کنید یک شرکت میتواند فروش کالاهای خود را برای کشورهای خاصی انجام دهد و برای فیلتر کردن کاربران، تنظیماتی را اعمال میکند که با دریافت اطلاعات مرورگر، در صورتی که \trans{آدرس آی پی}{IP Address} کاربر خارج از بازهی سرویس دهی شرکت باشد، از انجام تبلیغ صرف نظر کند. به این ترتیب این شرکت میزان قابل توجهی از هزینههای تبلیغاتی خود را از هدر رفت باز میدارد. | |||

| \end{itemize} | |||

| \item \textbf{مزایدهی بلادرنگ} | |||

| تفاوت مزایدههای بلادرنگ با معاملات تضمین شده، در مشخص کردن قیمت و تعداد دفعات نمایش دادن تبلیغات به کاربران است. در مزایدههای بلادرنگ، هزینهی هر تبلیغ به طور جداگانه در هنگام درخواست بارگیری صفحه توسط کاربر، توسط یک \trans{مزایده}{Auction} بین تبلیغ کنندگان تعیین میشود. | |||

| \begin{itemize} | |||

| \item \textbf{مزایدهی بلادرنگ آزاد} | |||

| در \trans{مزایدههای بلادرنگ آزاد}{Open Realtime Auction}، هربار که یک کاربر به یکی از صفحات دارای کادر مناسب برای تبلیغ وارد میشود، همهی تبلیغ کنندگان میتوانند یک قیمت برای نمایش تبلیغ خود به کاربر، پیشنهاد دهند و تبلیغ دارای بالاترین پیشنهاد قیمت، به کاربر نمایش داده میشود. امروزه این نوع معامله به دلیل هزینهی پایین برای تبلیغ کنندگان و درآمد بالا برای صاحبان صفحات وب، میزان قابل توجهی از تبلیغات کنندگان و صاحبان صفحات وب در سراسر جهان را به خود جذب کرده است. | |||

| \item \textbf{مزایدهی بلادرنگ خصوصی} | |||

| در \trans{مزایدههای بلادرنگ خصوصی}{Private Realtime Auction}، تبلیغات کنندگان باید قبل از شروع فرآیند تبلیغ وارد قرارداد شده و با قبول شرایط اولیهای که صاحب صفحات وب پیشنهاد میکند، وارد فرآیند مزایده شود. | |||

| \end{itemize} | |||

| \end{itemize} | |||

| \end{itemize} | |||

| در این پایان نامه، بر نوع مزایدههای بلادرنگ آزاد تمرکز خواهیم داشت و جزئیات و چالشهای مربوط به آن را بررسی خواهیم کرد. | |||

| \section{اجزا و نحوهی اجرای مزایدههای بلادرنگ} | |||

| در عمل، برای انجام مزایدههای بلادرنگ، به اجزا و نقشهای متنوعی نیاز است.\cite{yuan2014survey} در این بخش اصطلاحات استفاده شده در مزایدههای بلادرنگ و همچنین اجزا و نقشهای آن را تعریف کرده و توضیح میدهیم. | |||

| \subsection{کاربر} | |||

| تعریف کاربر در مزایدههای بلادرنگ، با تعریفی که در بخش قبل ذکر شد، تفاوت چندانی ندارد. تنها فرق جزئی در این نکته است که اینجا، تمرکز بیشتر روی مرورگری است که کاربر استفاده میکند و اعمالی که در این بخش به کاربر نسبت میدهیم، عملا توسط مرورگر کاربر انجام میشود و خود کاربر اطلاعی از انجام آنها ندارد. | |||

| \subsection{ناشر} | |||

| در ادبیات مزایدههای بلادرنگ، \trans{ناشر}{Publisher} به وبسایتی اشاره میکند که در آن امکان انجام تبلیغات وجود دارد و لذا [بخشی از] درآمد این وبسایت از تبلیغات است. از ملزومات اجرای فرآیند مزایدههای بلادرنگ، وجود اسکریپتهای مربوط به سکوی سمت تامین در این صفحه است. | |||

| \subsection{سکوی سمت تامین} | |||

| \trans{سکوی سمت تامین}{Supply Side Platform} | |||

| به بخشی از زیرساخت اطلاق میشود که با تعدادی ناشر قرارداد بسته و از طریق تعدادی اسکریپت که در سایت ناشرها تعبیه کرده است، اجرای فرآیند مزایده را ممکن میسازد. | |||

| این اسکریپتها، برخی اطلاعات از جمله سوابق مرور کاربر در همهی وبسایتهایی که این اسکریپت در آنها وجود دارد را به سکوی سمت تامین ارسال کرده و در هنگام نیاز به نمایش تبلیغ، اطلاعاتی از جمله موقعیت جغرافیایی، نحوهی اتصال به وبسایت (موبایل، تبلت یا کامپیوتر) و حتی نحوهی ورود به وبسایت (موتور جستجو، ایمیل تبلیغاتی، لینک توصیه شده از طرف کاربر دیگر و ...) را به این سکو ارسال میکند؛ لذا سکوی سمت تامین اطلاعات جامعی از این کاربر در اختیار داشته و بر اساس این اطلاعات، تبلیغات مناسب را در اختیار کاربر قرار دهد. | |||

| \subsection{سکوی سمت نیاز} | |||

| \trans{سکوی سمت نیاز}{Demand Side Platform} | |||

| به بخشی از زیرساخت اطلاق میشود که با تعدادی تبلیغ کننده (بازاریاب) ارتباط داشته و عملا شرکتکنندههای اصلی مزایده، آنها هستند. سکوهای سمت نیاز برای هر \trans{موقعیت قابل تبلیغ}{Impression} وارد مزایده شده و قیمت پیشنهادی خود را برای انجام تبلیغ ارائه میکنند. | |||

| \subsection{تبلیغ کننده} | |||

| تبلیغ کننده (\trans{بازاریاب}{Marketer}) در بخش قبلی به صورت کامل تعریف شده است. آنها برای انجام تبلیغ و بازاریابی کالا یا خدماتی که ارائه میدهند، دست به تبلیغ زده و بودجهی قابل توجهی را روانهی زیرساختهای تبلیغاتی میکنند. بازاریابها با سکوهای سمت نیاز قرارداد بسته و تبلیغات خود را به آنها ارائه کرده و به ازای تعداد کلیک کاربران روی تبلیغاتشان، به آنها پرداخت میکنند. به عنوان مثال، سکوی سمت نیاز در قراردادی تضمین میکند تعداد 1000 کلیک بر روی بنر تبلیغاتی یکی از تبلیغ کنندهها تامین کرده و در قبال آن، هزینهای دریافت کند. | |||

| \subsection{اجرای فرآیند مزایدههای بلادرنگ} | |||

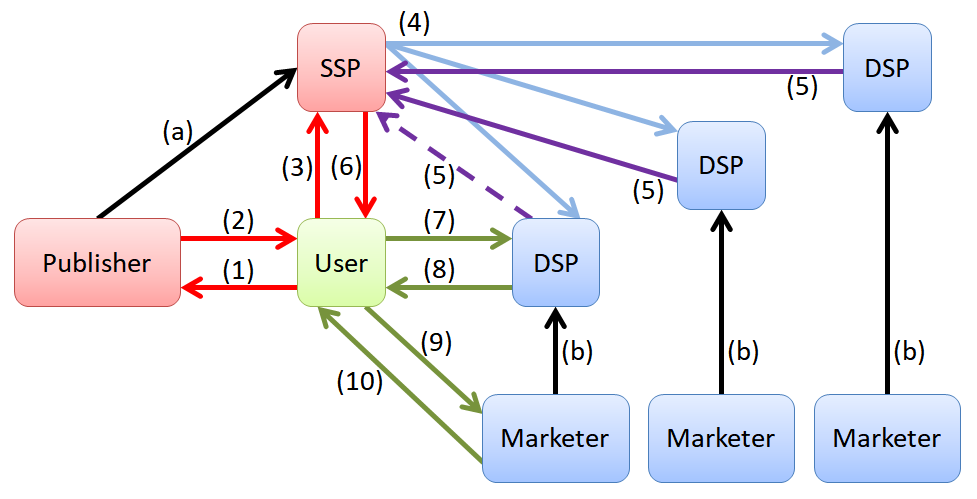

| فرآیند مزایدهی بلادرنگ، از کاربر شروع میشود. زمانی که کاربر وارد صفحهای متعلق به یک ناشر میشود، مرورگر کاربر یک درخواست برای نمایش وبسایت ناشر ارسال میکند(1). | |||

| وبسایت ناشر، صفحهی \trans{اچتیامال}{HTML} خود را برای کاربر ارسال کرده و همزمان لینک مربوط به اسکریپت سکوی سمت تامین را در اختیار کاربر میگذارد(2). | |||

| کاربر برای بارگیری صفحهی اچتیامال دریافتی، سراغ تکتک منابع رفته و هرکدام را بارگیری میکند. برای نمایش اطلاعاتی که در کادر تبلیغ وجود دارد، کاربر یک درخواست \trans{اچتیتیپی}{HTTP} به سکوی سمت تامین ارسال میکند(3). | |||

| در این مرحله، سکوی سمت تامین وارد عمل شده و موقعیت قابل تبلیغ و اطلاعات کاربر را از قبیل سابقهی کاربر، مشخصات و سابقهی سایت ناشر و اطلاعات مربوط به ابعاد کادر تبلیغ به تمامی سکوهای سمت نیاز در دسترس ارسال میکند(4). | |||

| هر سکوی سمت نیاز با در نظر گرفتن تبلیغِ خود، با استفاده از روشهای مختلف (که نمونههای آن در فصل 2 توضیح داده میشود) یک قیمت به عنوان هزینهی پیشنهادی نمایش تبلیغ ارائه میدهد. پیشنهادی که بیشترین قیمت را پیشنهاد داده باشد، برندهی مزایده میشود. پیشنهاد برنده با خطچین نمایش داده شده است(5). | |||

| پس از دریافت هزینههای پیشنهادی سکوهای سمت نیاز، سکوهای سمت تامین بالاترین قیمت را انتخاب کرده و لینک سکوی سمت نیاز برنده را به کاربر ارسال میکند(6). | |||

| کاربر با کسب اطلاع از آدرس مشخصات سکوی سمت نیاز برنده، برای اطلاع از محل نهایی بنر تبلیغ انتخاب شده، به آن آدرس رجوع میکند(7). | |||

| سکوی سمت نیاز برنده به درخواست کاربر پاسخ داده و آدرس بنر (که در سرور متعلق به بازاریاب است) را برای کاربر ارسال میکند(8). | |||

| کاربر به آدرس بنر رجوع میکند(9). | |||

| سرور بازاریاب بنر تبلیغ را به کاربر ارسال میکند(10). | |||

| مراحل اجرای این فرآیند در شکل \ref{fig:rtb-process} قابل ملاحظه است. | |||

| نکتهی قابل توجه در فرآیند مزایدهی بلادرنگ، تفاوت نوع قراردادهای بسته شده بین سکوهای سمت نیاز با تبلیغ کنندهها و سکوهای سمت تامین با ناشران است. سکوهای سمت تامین به ازای \textbf{نمایش} هر تبلیغ به ناشران مبلغی پرداخت میکنند؛ اما سکوهای سمت تامین به ازای هر \textbf{کلیک انجام شده} روی بنرهای تبلیغ کنندهها، مبلغی از آنها دریافت میکنند؛ بنابراین برای تضمین سوددهی این سیستم، باید تبلیغاتی برای نمایش به کاربران انتخاب شوند که احتمال کلیک شدن روی آنها قابل توجه باشد؛ پس تخمین این احتمال که به \trans{نرخ کلیک}{Click Through Rate} معروف است، به یک مسالهی محوری در این فرآیند تبدیل میشود.\cite{qin2019revenue} | |||

| لازم به ذکر است در برخی قراردادهای دیگر، نوع قرارداد بین سکوهای سمت تامین و تبلیغ کنندگان، به جای تضمین تعداد کلیک انجام شده، تضمین تعداد خرید انجام شده از طریق بنر مربوطه است؛ پس به جای تخمین نرخ کلیک، احتمال انجام خرید از طریق تبلیغ نمایش داده شده تخمین زده میشود که به \trans{نرخ تبدیل}{Convertion Rate} معروف است. در عمل میتوان نرخ تبدیل را ضریبی از نرخ کلیک در نظر گرفت که به دلیل تنک بودن، کار کردن با آن چالش بیشتری دارد. در این پژوهش به دلیل محدودیت در مجموعههای دادهی انتخاب شده، تنها از نرخ کلیک استفاده میکنیم. | |||

| \begin{figure} | |||

| \center | |||

| \includegraphics[width=0.9\textwidth]{images/RTB_Process} | |||

| \caption{ | |||

| فرآیند مزایدهی بلادرنگ | |||

| } | |||

| \label{fig:rtb-process} | |||

| \end{figure} | |||

| %================================================================== | |||

| \section{چالشها} | |||

| در تخمین نرخ کلیک و نرخ تبدیل، چالشهایی وجود دارند که کار پژوهش در این موضوع را دچار مشکل میکنند. در این بخش به اختصار در مورد این چالشها بحث میکنیم. | |||

| \begin{itemize} | |||

| \item \trans{چالش عدم توازن شدید کلاسها}{High class imbalance challenge} | |||

| هنگام دستهبندی دودویی در مسالهای که دادهها به صورت نامتوازن هستند، با چالش جدی عدم توازن کلاسها روبرو هستیم.\cite{reference/ml/LingS17} در تبلیغات نمایشی، در بیشتر موارد کاربر روی تبلیغ کلیک نمیکند و یا پس از کلیک، بازدید کاربر از صفحهی مقصد به خرید (تبدیل) منتهی نمیشود و این شرایط باعث میشود این مساله نیز جزء مسائل مواجه با چالش عدم توازن شدید کلاسها باشد. | |||

| \item \trans{چالش ابعاد بالا}{High dimentionality challenge} | |||

| به دلیل وجود تعداد ابعاد ورودی بسیار بالا، رویارویی با این مساله با الگوریتمهای سادهی یادگیری ممکن نیست. این مشکل با نام دیگر \trans{نفرین ابعاد}{Curse of dimentionality} نیز معروف است. نفرین ابعاد باعث میشود تعداد پارامترهای مدل بیشتر شده و در نتیجه فرآیند یادگیری آن دچار مشکلات متنوعی شود.\cite{pires2019high} | |||

| \item \trans{چالش شروع سرد}{Cold start challenge} | |||

| وقتی یک تبلیغ جدید برای نمایش اضافه میشود، سکوهای سمت نیاز هیچ اطلاعاتی در مورد آن و کاربرهایی که احتمالا به آن تبلیغ علاقه نشان دهند، ندارند؛ لذا تعداد زیادی از موقعیتهای قابل تبلیغ و در نتیجه میزان قابل توجهی هزینه صرف شناسایی تبلیغ جدید میشود. از طرفی، کاربر جدیدی که شروع به بازدید از صفحات مربوط به ناشرین میکند، از طرف سکوهای سمت تامین مورد نظر شناخته شده نیست؛ پس وقت و هزینهی زیادی صرف شناختن سلایق این کاربر جدید میشود. این مشکل در ادبیات \trans{سیستمهای پیشنهاد دهنده}{Recommender systems} به نام شروع سرد معروف است.\cite{journals/eswa/LikaKH14, DBLP:journals/corr/abs-1004-3732} | |||

| \item چالش سرعت آموزش | |||

| بسیاری از شرکتهایی که خدمات مربوط به مزایدههای بلادرنگ را ارائه میدهند، به دلیل تغییرات روزانهی زیاد در مجموعههای داده، عمل آموزش مدلهایشان را در فواصل زمانی کوتاه (مثلا هر روز) تکرار میکنند. پس مدلهایی که آموزش آنها زمانبر باشد، قابل استفاده در عمل نخواهند بود؛ لذا علاوه بر چالشهایی که ذکر شد، مدل ارائه شده باید توازنی بین عملکرد مناسب و سرعت آموزش ایجاد کند. | |||

| \end{itemize} | |||

| \section{هدف پژوهش} | |||

| در فرآیند مزایدههای بلادرنگ، تنها نکتهای که در آن اجماع عمومی وجود ندارد، روشی است که با آن نرخ کلیک یا نرخ تبدیل تخمین زده شده و هزینهی پرداختی به هر موقعیت قابل تبلیغ بر مبنای آن محاسبه و پیشنهاد میشود؛ لذا هدف کلی این پژوهش، ارائهی یک مدل یادگیری ماشین برای تخمین نرخ کلیک است. | |||

| \section{پرسشهای اساسی پژوهش} | |||

| برای رسیدن به هدف کلی این پژوهش که ارائهی یک راهکار جدید برای تخمین نرخ کلیک است، باید مشخص شود که \textbf{چه راهکاری برای مواجهه با چالشهای موجود، مناسب بوده و میتواند با وجود همهی این چالشها تخمین قابل قبولی از نرخ کلیک ارائه دهد؟} بنابراین، پرسشهای زیر پیشرویمان خواهد بود: | |||

| \begin{enumerate} | |||

| \item روشهای موجود برای تخمین نرخ کلیک در تبلیغات نمایشی، کدامند؟ | |||

| \item هریک از چالشهای مهم تخمین نرخ کلیک، چه تاثیری بر عملکرد روشها میگذارند؟ | |||

| \item روش مناسبی که با این چالشها رویارو شود، باید چه ویژگیهایی داشته باشد؟ | |||

| \end{enumerate} | |||

| \section{ساختار رساله} | |||

| در فصل دوم این رساله، پس از معرفی برخی از پیشنیازها، روشهای پیشین را معرفی، دستهبندی و مقایسه کرده و در مورد مزایا و معایب هرکدام در رویارویی با چالشهای مربوط به مساله میاندیشیم. در فصل سوم، با توجه به چالشها و کاستیهای روشهای پیشین، مدل پیشنهادی خود را گام به گام طراحی کرده و با ارائهی دلایل شهودی و ریاضی، ایدههای ارائه شده را توجیه میکنیم؛ سپس مدل پیشنهادی را فرمولهبندی کرده و پیشنیازهای لازم برای آموزش آن در چارچوب گرادیان کاهشی را ارائه مینماییم. با توجه به اکتشافی بودن فرآیند طراحی مدل پیشنهادی، بدون تثبیت گامهای ابتدایی، یافتن گامهای بعدی ممکن نخواهد بود؛ لذا با برداشتن هر گام، چگونگی اجرای گام بعدی خودنمایی خواهد کرد. در فصل چهارم، پس از معرفی مجموعههای داده و معیارهای ارزیابی استفاده شده، آزمایشهای گوناگونی را طراحی و اجرا کرده و بر اساس نتایج این آزمایشها، مدل پیشنهادی را از ابعاد مختلف سنجیده و سپس آن را با روشهای پیشین مقایسه میکنیم. در فصل پنجم این رساله، از پژوهش انجام شده نتیجه گیری کرده و گامهایی را برای ادامهی پژوهش در این مسیر معرفی مینماییم. | |||

+ 312

- 0

Thesis/chap2.aux

View File

| @@ -0,0 +1,312 @@ | |||

| \relax | |||

| \providecommand\zref@newlabel[2]{} | |||

| \providecommand\hyper@newdestlabel[2]{} | |||

| \citation{boser1992} | |||

| \zref@newlabel{zref@35}{\abspage{17}\page{10}\pagevalue{10}} | |||

| \@writefile{toc}{\contentsline {chapter}{فصل\nobreakspace {}\numberline {2}پژوهشهای پیشین}{10}{chapter.2}} | |||

| \@writefile{lof}{\addvspace {10\p@ }} | |||

| \@writefile{lot}{\addvspace {10\p@ }} | |||

| \newlabel{Chap:Chap2}{{2}{10}{پژوهشهای پیشین}{chapter.2}{}} | |||

| \@writefile{toc}{\contentsline {section}{\numberline {2-1}روشهای کلاسیک}{10}{section.2.1}} | |||

| \zref@newlabel{footdir@75}{\abspage{17}} | |||

| \zref@newlabel{zref@36}{\abspage{17}\page{10}\pagevalue{10}} | |||

| \zref@newlabel{footdir@81}{\abspage{17}} | |||

| \zref@newlabel{footdir@76}{\abspage{17}} | |||

| \@writefile{toc}{\contentsline {subsection}{\numberline {2-1-1}ماشینهای بردار پشتیبان}{11}{subsection.2.1.1}} | |||

| \zref@newlabel{footdir@79}{\abspage{18}} | |||

| \zref@newlabel{zref@38}{\abspage{18}\page{11}\pagevalue{11}} | |||

| \zref@newlabel{footdir@77}{\abspage{18}} | |||

| \zref@newlabel{zref@37}{\abspage{18}\page{11}\pagevalue{11}} | |||

| \zref@newlabel{footdir@82}{\abspage{18}} | |||

| \zref@newlabel{footdir@78}{\abspage{18}} | |||

| \zref@newlabel{footdir@80}{\abspage{18}} | |||

| \citation{Gai_piecewise} | |||

| \citation{lecun_sgd} | |||

| \@writefile{toc}{\contentsline {subsubsection}{مدل تکهای خطی\cite {Gai_piecewise}}{12}{section*.5}} | |||

| \zref@newlabel{footdir@83}{\abspage{19}} | |||

| \zref@newlabel{zref@39}{\abspage{19}\page{12}\pagevalue{12}} | |||

| \zref@newlabel{footdir@85}{\abspage{19}} | |||

| \zref@newlabel{zref@40}{\abspage{19}\page{12}\pagevalue{12}} | |||

| \zref@newlabel{footdir@87}{\abspage{19}} | |||

| \zref@newlabel{zref@41}{\abspage{19}\page{12}\pagevalue{12}} | |||

| \zref@newlabel{footdir@89}{\abspage{19}} | |||

| \zref@newlabel{zref@42}{\abspage{19}\page{12}\pagevalue{12}} | |||

| \zref@newlabel{footdir@91}{\abspage{19}} | |||

| \zref@newlabel{footdir@84}{\abspage{19}} | |||

| \zref@newlabel{footdir@86}{\abspage{19}} | |||

| \zref@newlabel{footdir@88}{\abspage{19}} | |||

| \zref@newlabel{footdir@90}{\abspage{19}} | |||

| \citation{lbfgs_2008} | |||

| \citation{Graepel_2010} | |||

| \zref@newlabel{footdir@94}{\abspage{20}} | |||

| \zref@newlabel{zref@44}{\abspage{20}\page{13}\pagevalue{13}} | |||

| \zref@newlabel{footdir@92}{\abspage{20}} | |||

| \zref@newlabel{zref@43}{\abspage{20}\page{13}\pagevalue{13}} | |||

| \zref@newlabel{footdir@96}{\abspage{20}} | |||

| \zref@newlabel{zref@45}{\abspage{20}\page{13}\pagevalue{13}} | |||

| \zref@newlabel{footdir@98}{\abspage{20}} | |||

| \zref@newlabel{zref@46}{\abspage{20}\page{13}\pagevalue{13}} | |||

| \@writefile{toc}{\contentsline {subsubsection}{مدل بیزی\cite {Graepel_2010}}{13}{section*.6}} | |||

| \zref@newlabel{footdir@102}{\abspage{20}} | |||

| \zref@newlabel{zref@48}{\abspage{20}\page{13}\pagevalue{13}} | |||

| \zref@newlabel{footdir@100}{\abspage{20}} | |||

| \zref@newlabel{zref@47}{\abspage{20}\page{13}\pagevalue{13}} | |||

| \zref@newlabel{footdir@106}{\abspage{20}} | |||

| \zref@newlabel{zref@50}{\abspage{20}\page{13}\pagevalue{13}} | |||

| \zref@newlabel{footdir@104}{\abspage{20}} | |||

| \zref@newlabel{zref@49}{\abspage{20}\page{13}\pagevalue{13}} | |||

| \zref@newlabel{footdir@108}{\abspage{20}} | |||

| \zref@newlabel{zref@51}{\abspage{20}\page{13}\pagevalue{13}} | |||

| \zref@newlabel{footdir@110}{\abspage{20}} | |||

| \zref@newlabel{footdir@93}{\abspage{20}} | |||

| \zref@newlabel{footdir@95}{\abspage{20}} | |||

| \zref@newlabel{footdir@97}{\abspage{20}} | |||

| \zref@newlabel{footdir@99}{\abspage{20}} | |||

| \zref@newlabel{footdir@101}{\abspage{20}} | |||

| \zref@newlabel{footdir@103}{\abspage{20}} | |||

| \zref@newlabel{footdir@105}{\abspage{20}} | |||

| \zref@newlabel{footdir@107}{\abspage{20}} | |||

| \zref@newlabel{footdir@109}{\abspage{20}} | |||

| \zref@newlabel{footdir@111}{\abspage{21}} | |||

| \zref@newlabel{zref@52}{\abspage{21}\page{14}\pagevalue{14}} | |||

| \zref@newlabel{footdir@113}{\abspage{21}} | |||

| \zref@newlabel{zref@53}{\abspage{21}\page{14}\pagevalue{14}} | |||

| \zref@newlabel{footdir@117}{\abspage{21}} | |||

| \zref@newlabel{zref@55}{\abspage{21}\page{14}\pagevalue{14}} | |||

| \zref@newlabel{footdir@115}{\abspage{21}} | |||

| \zref@newlabel{zref@54}{\abspage{21}\page{14}\pagevalue{14}} | |||

| \zref@newlabel{footdir@119}{\abspage{21}} | |||

| \zref@newlabel{footdir@112}{\abspage{21}} | |||

| \zref@newlabel{footdir@114}{\abspage{21}} | |||

| \zref@newlabel{footdir@116}{\abspage{21}} | |||

| \zref@newlabel{footdir@118}{\abspage{21}} | |||

| \@writefile{toc}{\contentsline {subsection}{\numberline {2-1-2}ماشینهای فاکتورگیری}{15}{subsection.2.1.2}} | |||

| \zref@newlabel{footdir@120}{\abspage{22}} | |||

| \zref@newlabel{zref@56}{\abspage{22}\page{15}\pagevalue{15}} | |||

| \@writefile{toc}{\contentsline {subsubsection}{ایدهی فیلدها و شیوهی نگرش به دادهها در ماشینهای فاکتورگیری}{15}{section*.7}} | |||

| \zref@newlabel{footdir@122}{\abspage{22}} | |||

| \zref@newlabel{zref@57}{\abspage{22}\page{15}\pagevalue{15}} | |||

| \zref@newlabel{footdir@124}{\abspage{22}} | |||

| \zref@newlabel{zref@58}{\abspage{22}\page{15}\pagevalue{15}} | |||

| \zref@newlabel{footdir@126}{\abspage{22}} | |||

| \zref@newlabel{zref@59}{\abspage{22}\page{15}\pagevalue{15}} | |||

| \zref@newlabel{footdir@128}{\abspage{22}} | |||

| \zref@newlabel{zref@60}{\abspage{22}\page{15}\pagevalue{15}} | |||

| \zref@newlabel{footdir@130}{\abspage{22}} | |||

| \zref@newlabel{zref@61}{\abspage{22}\page{15}\pagevalue{15}} | |||

| \zref@newlabel{footdir@134}{\abspage{22}} | |||

| \zref@newlabel{footdir@121}{\abspage{22}} | |||

| \zref@newlabel{footdir@123}{\abspage{22}} | |||

| \zref@newlabel{footdir@125}{\abspage{22}} | |||

| \zref@newlabel{footdir@127}{\abspage{22}} | |||

| \zref@newlabel{footdir@129}{\abspage{22}} | |||

| \zref@newlabel{footdir@131}{\abspage{22}} | |||

| \citation{Rendle:2010ja} | |||

| \zref@newlabel{footdir@132}{\abspage{23}} | |||

| \zref@newlabel{zref@62}{\abspage{23}\page{16}\pagevalue{16}} | |||

| \@writefile{toc}{\contentsline {subsubsection}{ماشینهای فاکتورگیری ساده\cite {Rendle:2010ja}}{16}{section*.8}} | |||

| \zref@newlabel{footdir@135}{\abspage{23}} | |||

| \zref@newlabel{zref@63}{\abspage{23}\page{16}\pagevalue{16}} | |||

| \zref@newlabel{footdir@139}{\abspage{23}} | |||

| \zref@newlabel{footdir@133}{\abspage{23}} | |||

| \zref@newlabel{footdir@136}{\abspage{23}} | |||

| \citation{Juan_fieldawarefm1} | |||

| \citation{Juan_fieldawarefm2} | |||

| \zref@newlabel{footdir@137}{\abspage{24}} | |||

| \zref@newlabel{zref@64}{\abspage{24}\page{17}\pagevalue{17}} | |||

| \zref@newlabel{footdir@140}{\abspage{24}} | |||

| \zref@newlabel{zref@65}{\abspage{24}\page{17}\pagevalue{17}} | |||

| \@writefile{toc}{\contentsline {subsubsection}{ماشینهای فاکتورگیری آگاه از فیلد\cite {Juan_fieldawarefm1, Juan_fieldawarefm2}}{17}{section*.9}} | |||

| \zref@newlabel{footdir@142}{\abspage{24}} | |||

| \zref@newlabel{footdir@138}{\abspage{24}} | |||

| \zref@newlabel{footdir@141}{\abspage{24}} | |||

| \citation{Pan_fieldweightedfm} | |||

| \@writefile{toc}{\contentsline {subsubsection}{ماشینهای فاکتورگیری با فیلدهای وزندار\cite {Pan_fieldweightedfm}}{18}{section*.10}} | |||

| \citation{Freudenthaler2011BayesianFM} | |||

| \zref@newlabel{footdir@143}{\abspage{26}} | |||

| \zref@newlabel{zref@66}{\abspage{26}\page{19}\pagevalue{19}} | |||

| \@writefile{toc}{\contentsline {subsubsection}{ماشینهای فاکتورگیری تنک}{19}{section*.11}} | |||

| \zref@newlabel{footdir@145}{\abspage{26}} | |||

| \zref@newlabel{footdir@144}{\abspage{26}} | |||

| \citation{Pan_sparsefm} | |||

| \zref@newlabel{footdir@146}{\abspage{27}} | |||

| \zref@newlabel{zref@67}{\abspage{27}\page{20}\pagevalue{20}} | |||

| \zref@newlabel{footdir@148}{\abspage{27}} | |||

| \zref@newlabel{zref@68}{\abspage{27}\page{20}\pagevalue{20}} | |||

| \zref@newlabel{footdir@150}{\abspage{27}} | |||

| \zref@newlabel{zref@69}{\abspage{27}\page{20}\pagevalue{20}} | |||

| \zref@newlabel{footdir@152}{\abspage{27}} | |||

| \zref@newlabel{zref@70}{\abspage{27}\page{20}\pagevalue{20}} | |||

| \zref@newlabel{footdir@154}{\abspage{27}} | |||

| \zref@newlabel{footdir@147}{\abspage{27}} | |||

| \zref@newlabel{footdir@149}{\abspage{27}} | |||

| \zref@newlabel{footdir@151}{\abspage{27}} | |||

| \zref@newlabel{footdir@153}{\abspage{27}} | |||

| \citation{Xiao_afm} | |||

| \zref@newlabel{footdir@155}{\abspage{28}} | |||

| \zref@newlabel{zref@71}{\abspage{28}\page{21}\pagevalue{21}} | |||

| \zref@newlabel{footdir@157}{\abspage{28}} | |||

| \zref@newlabel{zref@72}{\abspage{28}\page{21}\pagevalue{21}} | |||

| \zref@newlabel{footdir@159}{\abspage{28}} | |||

| \zref@newlabel{zref@73}{\abspage{28}\page{21}\pagevalue{21}} | |||

| \zref@newlabel{footdir@161}{\abspage{28}} | |||

| \zref@newlabel{zref@74}{\abspage{28}\page{21}\pagevalue{21}} | |||

| \@writefile{toc}{\contentsline {subsubsection}{ماشین فاکتورگیری با توجه\cite {Xiao_afm}}{21}{section*.12}} | |||

| \zref@newlabel{footdir@163}{\abspage{28}} | |||

| \zref@newlabel{zref@75}{\abspage{28}\page{21}\pagevalue{21}} | |||

| \zref@newlabel{footdir@165}{\abspage{28}} | |||

| \zref@newlabel{footdir@156}{\abspage{28}} | |||

| \zref@newlabel{footdir@158}{\abspage{28}} | |||

| \zref@newlabel{footdir@160}{\abspage{28}} | |||

| \zref@newlabel{footdir@162}{\abspage{28}} | |||

| \zref@newlabel{footdir@164}{\abspage{28}} | |||

| \citation{srivastava2014dropout} | |||

| \citation{tikhonov1943stability} | |||

| \citation{journals/corr/ZhangYS17aa} | |||

| \zref@newlabel{footdir@168}{\abspage{29}} | |||

| \zref@newlabel{zref@77}{\abspage{29}\page{22}\pagevalue{22}} | |||

| \zref@newlabel{footdir@166}{\abspage{29}} | |||

| \zref@newlabel{zref@76}{\abspage{29}\page{22}\pagevalue{22}} | |||

| \zref@newlabel{footdir@170}{\abspage{29}} | |||

| \zref@newlabel{footdir@167}{\abspage{29}} | |||

| \zref@newlabel{footdir@169}{\abspage{29}} | |||

| \citation{Chen_deepctr} | |||

| \citation{he2015residual} | |||

| \citation{Nair_relu} | |||